-

Conheça os frameworks de aprendizado de máquina e IA nas plataformas Apple

Confira as atualizações mais recentes de frameworks de aprendizado de máquina e IA disponíveis nas plataformas Apple. Não importa se você é um desenvolvedor de apps que deseja explorar a Apple Intelligence, um engenheiro de ML otimizando modelos para implantação no dispositivo ou um entusiasta de IA explorando possibilidades, ofereceremos orientações para ajudar você a escolher as ferramentas certas para suas necessidades.

Capítulos

- 0:00 - Introdução

- 1:18 - Inteligência da plataforma

- 8:20 - APIs viabilizadas por ML

- 11:15 - Modelos de ML

- 14:54 - Exploração

Recursos

-

Buscar neste vídeo...

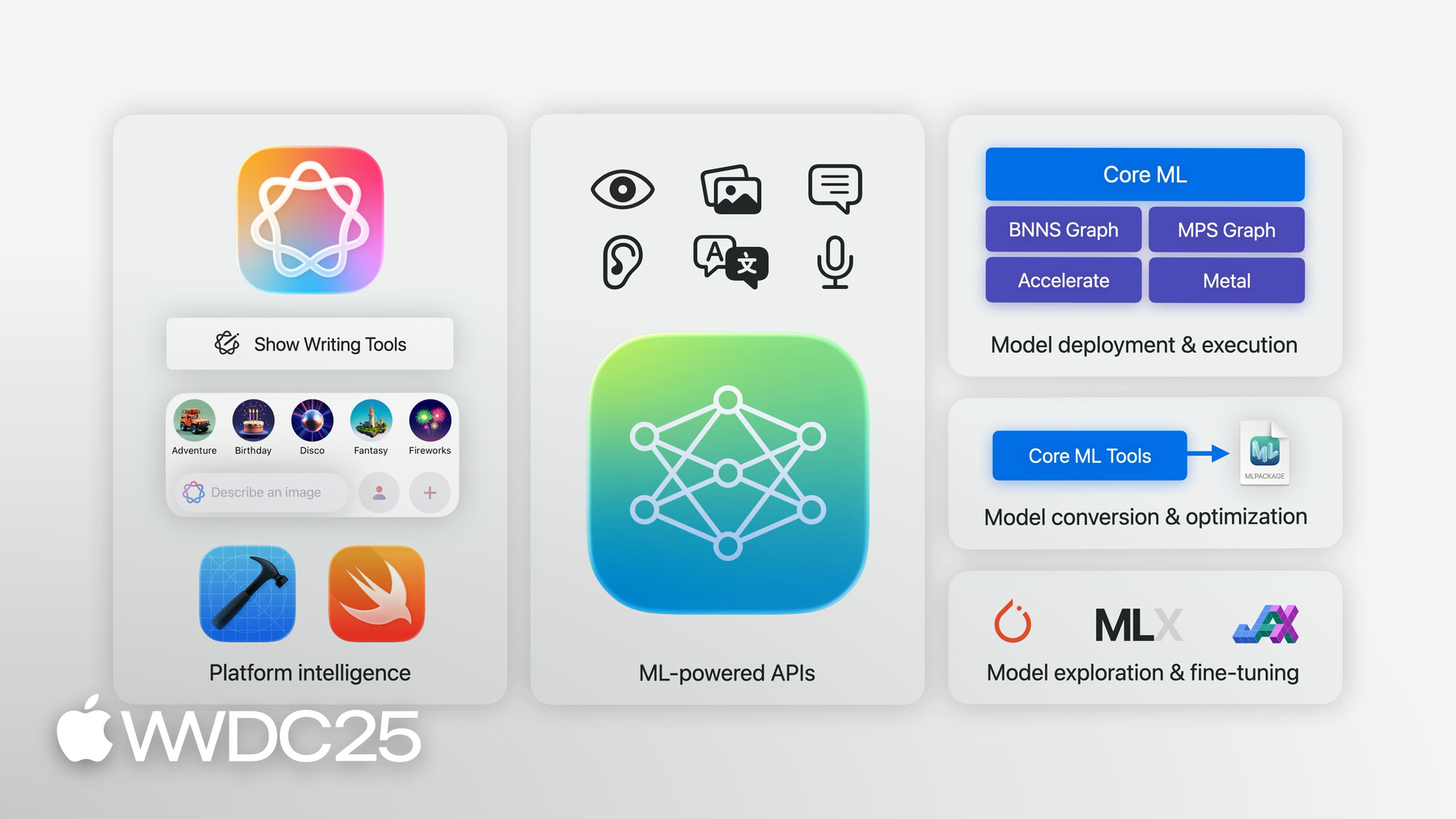

Olá! Sou Jaimin Upadhyay, engineering manager da equipe On-Device Machine Learning da Apple. Hoje, gostaria de falar como você pode usar a Apple Intelligence e o aprendizado de máquina nos apps e projetos personalizados. Se você é desenvolvedor de apps e quer explorar a Apple Intelligence na interface ou no código, é engenheiro de ML convertendo e otimizando modelos para implantação no dispositivo ou é entusiasta de IA explorando a fronteira do que se pode fazer no Mac, temos as ferramentas certas. Mostrarei uma visão geral dessas ferramentas, destacarei as novidades e indicarei os recursos para você aprofundar seu conhecimento. Vamos começar com uma visão geral da inteligência integrada ao sistema operacional e sua relação com o app. Em seguida, vamos explorar como você pode acessar programaticamente essa inteligência com nossos frameworks de sistema. Então, vamos abordar como as ferramentas e APIs da Apple podem ajudar a otimizar e implantar modelos de aprendizado de máquina no dispositivo. E vamos concluir discutindo como você pode ficar por dentro das inovações em ML e IA no hardware da Apple.

Temos um longo e emocionante roteiro para cobrir, então vamos começar. Primeiro, a inteligência de plataforma. O aprendizado de máquina e a inteligência artificial estão no centro de muitos recursos e apps integrados em nosso sistema operacional. Seja para autenticação com Optic ID no Apple Vision Pro, compreensão da caligrafia para ajudar em cálculos no iPad ou remoção de ruído para melhorar a qualidade da voz no FaceTime, o aprendizado de máquina está no centro de tudo. Os modelos de ML que impulsionam esses recursos foram treinados e otimizados para eficiência no dispositivo. O ano passado foi o início de um novo capítulo: trazer a inteligência generativa para o núcleo de nossos sistemas operacionais, com grandes modelos de base que alimentam a Apple Intelligence. Isso trouxe a Ferramentas de Escrita, o Genmoji e o Image Playground para todo o sistema, facilitando a integração desses recursos com seus apps. Se você estiver usando controles de texto do sistema, o suporte a Genmoji será ativado automaticamente. Você pode até usar as APIs para que eles apareçam diretamente no texto. O framework Image Playground fornece extensões da interface Swift para visualizar o imagePlaygroundSheet em seu app. E, para a maioria, seus apps já estavam configurados para oferecer suporte às Ferramentas de Escrita ao usar estruturas de interface padrão para exibir textViews. É simples assim. Você pode usar os modos de visualização padrão ou adicionar algumas linhas de código aos modos personalizados. Dessa forma, seus usuários podem acessar facilmente a Apple Intelligence dentro dos apps, com uma interface consistente e familiar. E se você quiser ir além da interface padrão ou precisar de mais controle? Isso nos leva ao tópico de APIs com ML, que fornecem acesso programático a modelos e recursos do sistema. Disponibilizamos uma grande variedade dessas APIs. Algumas dão acesso a modelos de sistema proeminentes com utilitários essenciais, outras disponibilizam APIs práticas para tarefas especializadas de ML. Vamos explorá-la revisitando como você pode integrar a geração de imagens a seu app. O iOS 18.4 introduziu a classe ImageCreator no framework Image Playground. Essa classe permite criar imagens programaticamente. Basta instanciar o criador da imagem. Solicite imagens com base em algumas ideias. Aqui, usamos um prompt de texto e um estilo selecionado. Você pode mostrá-los ou usá-los em seu app como preferir. Também na versão 18.4, introduzimos a API Smart Reply. Você pode permitir que seus usuários escolham respostas inteligentes para e-mails e mensagens, delegando o contexto para um teclado. Vamos descobrir rapidamente como configurar essa API. Para delegar a conversa, configure UIMessage ou UIMail ConversationContext com seus dados e defina-o sem sua visualização de entrada antes que o teclado seja solicitado. Quando uma resposta inteligente do teclado é selecionada para uma mensagem instantânea, ela é inserida no documento. Em uma conversa de e-mail, a seleção é delegada novamente ao método de delegado insertInputSuggestion correspondente da visualização. Você pode criar e inserir suas próprias respostas mais longas e apropriadas para um e-mail. Para saber mais, consulte a página de documentação "Adotar a Resposta Inteligente no app de mensagens ou de e-mail". Tudo isso é executado no dispositivo e usa os modelos de base da Apple. No iOS 26, vamos ainda mais longe com a introdução do framework Foundation Models. Ele fornece acesso programático a um modelo de linguagem especializado para tarefas diárias e superotimizado no dispositivo. Ele pode alimentar esses recursos em todos os apps. É ótimo para fazer resumo, extração, classificação e muito mais. Você pode usá-lo para aprimorar os recursos dos apps, como fornecer sugestões de busca personalizadas. Também pode criar outros recursos, como gerar um itinerário em um app de viagem.

Pode até usá-lo para criar um diálogo espontâneos para personagens em um jogo. Esse é o meu favorito!

Usar os prompts de modelo é muito fácil. Importe o framework, crie uma sessão e envie seu prompt para o modelo. Como o framework opera no dispositivo, os dados do usuário permanecem privados e não precisam ser enviados para outros lugares. Os recursos de IA estão prontamente disponíveis e funcionam offline, eliminando a necessidade de configurar uma conta ou obter chaves de API. E tudo isso sem custo para você ou seus usuários, independentemente das solicitações. O framework Foundation Models não é apenas um simples prompt de respostas de texto. Às vezes, você precisa de um LLM para gerar respostas estruturadas que possam ser usadas diretamente no app. Isso é fácil com o framework Foundation Models. Você pode aproveitar os tipos existentes em seu app e marcá-los como geráveis. Adicione também alguns guias de linguagem natural a cada propriedade, além de controles opcionais sobre os valores gerados. Isso permite que você use o Guided Generation com um prompt simples. Quando você indica a resposta para gerar seu tipo.

O framework personaliza o loop de decodificação do modelo de linguagem e impede que o modelo cometa erros estruturais. Sua estrutura de dados é preenchida com as informações corretas, para que você não precise lidar com esquemas JSON. Apenas concentre-se no prompt. O framework faz todo o resto! A integração entre Swift, framework e tipos personalizados facilita a iteração e a exploração rápida de novas ideias dentro do app.

Ao desenvolver seu caso de uso, é importante considerar o conhecimento disponível para o modelo de base. Além das informações fornecidas por meio de prompts e descrições geráveis de tipos, o modelo tem um conjunto principal de conhecimento derivado dos dados em que foi treinado. Esses dados foram fixados no tempo e não contêm eventos recentes. Embora seja incrivelmente poderoso para um modelo em escala de dispositivo, esse modelo não é tão experiente quanto modelos maiores em escala de servidor. Para ajudar em casos de uso que exigem conhecimento adicional do app ou da rede, o framework Foundation Models oferece suporte à chamada de ferramentas. A chamada de ferramentas permite que você vá além da geração de texto e execute algumas ações. Ela fornece ao modelo acesso a dados em tempo real ou pessoais, como clima e eventos do calendário, não apenas o que foi treinado meses atrás. E pode até possibilitar que o modelo cite fontes de verdade, permitindo aos usuários verifiquem as saídas. Por fim, as ferramentas também podem executar ações reais, seja no app, no sistema ou no mundo real.

Essa foi apenas uma prévia das impressionantes capacidades do framework, mas há muito mais. Para obter uma introdução mais detalhada, confira à sessão "Conheça o framework Foundation Models". Nessa sessão, você também aprenderá sobre respostas de fluxo contínuo, sessões com estado e integração do framework com o Xcode. Se preferir aprender na prática, temos uma sessão de codificação guiada para você criar seu primeiro app inteligente usando as novas APIs. Também temos um sessão dedicada a considerações de design para seus casos de uso. Seu foco são as melhores práticas para ajudar você a escrever prompts reflexivos, considerar aspectos de segurança de IA, conhecer as possibilidades de um modelo de linguagem em escala de dispositivo e aplicar estratégias sólidas para avaliar e testar a qualidade e a segurança. Não deixe de conferir "Explore a criação de prompts e a segurança de IA para modelos no dispositivo" para saber mais.

O novo framework Foundation Models se junta ao pacote de outras APIs e ferramentas com aprendizado de máquina, para você aproveitar a inteligência no dispositivo para os recursos do seu app. Esses frameworks se concentram em um domínio específico com modelos específicos de tarefas altamente otimizados. Temos o Vision, para entender o conteúdo de imagens e vídeos. O Natural Language, para identificar linguagem, partes da fala e entidades nomeadas em texto de linguagem natural. O Translation, para realizar traduções de texto entre vários idiomas. O Sound Analysis, para reconhecer muitas categorias de som. E o Speech, para identificar e transcrever palavras faladas em áudio. E apenas com algumas linhas de código. Vou destacar algumas novidades interessantes desses frameworks neste ano.

Começando com o Vision. O Vision tem mais de 30 APIs para diferentes tipos de análise de imagens. Hoje, o Vision está adicionando duas novas APIs. O Vision traz melhorias para o reconhecimento de texto. Em vez de apenas ler linhas de texto, o Vision agora fornece reconhecimento de documentos. Ele agrupa diferentes estruturas de documentos, facilitando o processamento e a compreensão de documentos.

O Vision tem um novo modo de detecção de manchas na lente. Ele ajuda a identificar manchas na lente da câmera que comprometem a qualidade das imagens. Para obter mais informações sobre a detecção de manchas na lente e as outras novidades interessantes do Vision, confira o sessão "Leia documentos usando o framework Vision".

Agora, vamos falar sobre o framework Speech. A classe SFSpeechRecognizer no framework Speech deu acesso ao modelo de conversão de fala em texto que alimenta a Siri e funcionou bem para ditados curtos. Agora, no iOS 26, estamos introduzindo a nova API SpeechAnalyzer, que oferece suporte a muito mais casos de uso e usa o poder do Swift. A nova API executa o processamento da conversão de fala em texto com pouquíssima codificação e inteiramente no dispositivo.

Junto com a API, fornecemos um novo modelo de conversão fala em texto que é mais rápido e flexível do que o anterior.

Você passa buffers de áudio para a instância do analisador, que os roteia pelo novo modelo de conversão de fala em texto. O modelo prevê o texto que corresponde ao áudio falado e o retorna ao seu app. O novo modelo é especialmente bom para áudios longos e à distância, como palestras, reuniões e conversas. Confira à sessão "Integre a conversão de fala em texto avançada ao seu app com o SpeechAnalyzer" para se aprofundar mais.

As APIs baseadas em ML da Apple oferecem toneladas de recursos que os app podem aproveitar imediatamente! E muitas dessas APIs podem ser estendidas ou personalizadas para seu caso de uso específico.

O app Create ML e o framework permitem ajustar os modelos do sistema com seus próprios dados. Crie seu próprio classificador de imagens para usar com o framework Vision ou um marcador de palavras personalizado para usar com o Natural Language. Você pode até ampliar os recursos do Vision Pro para reconhecer e rastrear objetos específicos com seis graus de liberdade para experiências espaciais.

Já falamos como você pode aproveitar ou estender os recursos por ML e IA integrados ao sistema. A seguir, vamos abordar como aplicar qualquer modelo ao dispositivo. Ao escolher e integrar um modelo ao app, há muitos fatores a serem considerados. Mas isso é simplificado pelo Core ML. Você só precisa de um modelo no formato Core ML. Esses ativos de modelo contêm uma descrição das entradas, saídas e arquitetura do modelo, além dos parâmetros aprendidos.

Você pode encontrar vários modelos abertos no formato Core ML em developer.apple.com prontos para uso.

Eles estão categorizados, contém uma descrição dos recursos de cada modelo e uma lista de variações diferentes, além de informações de desempenho geral em diferentes dispositivos.

Da mesma forma, você pode querer verificar o espaço Apple no Hugging Face. Além dos modelos que já estão em formato Core ML, você também encontrará links para a definição do modelo de origem.

Essas configurações de modelo são frequentemente expressas no PyTorch, juntamente com pipelines de treinamento e ajuste.

O Core ML Tools oferece utilitários e fluxos de trabalho para transformar modelos treinados no formato de modelo Core ML. Esses fluxos de trabalho não apenas traduzem diretamente a representação do modelo, mas também aplicam otimizações para execução no dispositivo. Algumas dessas otimizações são automáticas, como a fusão de operações e a eliminação de cálculos redundantes. No entanto, o coremltools também fornece uma pacote de técnicas de compressão de modelos, inclusive ajuste fino e pós-treinamento. Isso ajudará você a reduzir o tamanho de seu modelo e a melhorar seu desempenho de inferência em termos de memória, potência e latência.

Essas técnicas são opcionais e permitem que você explore diferentes compensações entre desempenho e precisão do modelo.

Saiba mais na sessão "Bring your models to Apple Silicon" da WWDC24. Verifique as notas de lançamentos mais recentes e os exemplos no guia do usuário.

Quando seu modelo estiver no formato Core ML, você poderá integrá-lo ao Xcode. Você pode inspecionar as principais características do modelo ou explorar seu desempenho em um dispositivo conectado. Pode obter insights sobre latência esperada das previsões e tempos de carregamento, além de analisar onde uma determinada operação tem suporte e é executada, diretamente no Xcode. Novidade neste ano, você pode visualizar a estrutura completa da arquitetura do modelo e explorar os detalhes de qualquer operação. Essa nova visualização ajuda a compreender melhor o modelo com o qual está trabalhando, tornando as oportunidades de depuração e desempenho mais visíveis.

Aode codificar, o Xcode gera uma interface segura de tipo, específica para o seu modelo, em Swift. E a integração ocorre em apenas algumas linhas de código. Em tempo de execução, o Core ML usa toda a computação disponível, otimizando a execução entre CPU, GPU e Neural Engine.

Embora o Core ML seja o framework ideal para implantar modelos no dispositivo, pode haver cenários em que você precise de um controle mais refinado. Por exemplo, se precisar sequenciar ou integrar o ML com carga de trabalho gráfica, você poderá usar modelos Core ML com MPS Graph e Metal. Ou, ao executar o processamento de sinal em tempo real na CPU, a API BNNS Graph da Accelerate fornece controle rigoroso de latência e gerenciamento de memória para sua tarefa de ML.

Esses frameworks compõem a base do Core ML e estão acessíveis para você.

Este ano, há novos recursos da BNNSGraph, entre eles, o novo Graph Builder, que permite à equipe de desenvolvimento criar gráficos de operações. Isso significa que você pode escrever rotinas de pré e pós-processamento ou pequenos modelos de ML para serem executados em tempo real na CPU. Confira "Novidades da BNNS Graph" para saber mais.

Por fim, vamos falar como você pode acompanhar o desenvolvimento acelerado do aprendizado de máquina e como a plataforma Apple pode ajudar. A pesquisa de ML está avançando em um ritmo rápido, há novidades todos os dias. Novos modelos e técnicas são explorados e criados a um ritmo sem precedentes. Há muita coisa para acompanhar. Isso pode ser um grande desafio sem as ferramentas e os recursos certos. Para acompanhar a fronteira atual de exploração, é preciso ter a capacidade de executar grandes modelos, explorar arquiteturas únicas e aprender com uma comunidade aberta. Temos ferramentas e recursos sofisticados para seus empreendimentos para explorar a fronteira. Uma dessas ferramentas poderosas é o MLX.

É um framework de matriz para computação numérica e aprendizado de máquina. Ele foi projetado pela equipe de pesquisadores de ML da Apple e totalmente desenvolvido como código aberto. O MLX dá acesso a modelos avançados e a capacidade de realizar ajustes finos, treinamento e aprendizado distribuídos eficientes em máquinas com Apple Silicon.

O MLX pode executar inferência de ML avançada em modelos de linguagem grandes, como o Mistral, com uma única chamada de linha de comando. Por exemplo, aqui está gerando código para classificação rápida com um comprimento máximo de token de 1.024.

Isso permite que você acompanhe de perto as pesquisas de ponta, graças à comunidade de código aberto, que trabalha para que esses modelos funcionem com o MLX. A comunidade MLX no Hugging Face tem centenas de modelos de fronteira prontamente disponíveis para você por meio de uma linha de código. Confira a sessão "Explore os LLMs (grandes modelos de linguagem) no Apple Silicon com o MLX" para saber como você pode executar o Deep-Sea Car 1 em sua máquina com Apple Silicon.

O MLX foi projetado para extrair o melhor do Apple Silicon. Isso inclui um novo modelo de programação específico para memória unificada. A maioria dos sistemas comumente usados para aprendizado de máquina tem uma GPU dedicada com memória separada. Os dados geralmente são residentes e vinculados a um dispositivo específico. As operações são executadas onde estão os dados. Não é possível executar com eficiência as operações que usam os dados de vários pools de memória. Eles exigiriam uma cópia na memória. O Apple Silicon, por outro lado, tem uma arquitetura de memória unificada. Isso significa que a CPU e a GPU compartilham a mesma memória física. As matrizes no MLX não estão vinculadas a um dispositivo, mas as operações estão, permitindo executar operações diferentes na CPU e na GPU em paralelo no mesmo buffer.

Confira a sessão "Introdução ao MLX para Apple Silicon" para saber mais sobre esse modelo de programação exclusivo e outros recursos do MLX. Você pode até ajustar seu modelo com uma única linha de código e aumentar a escala conforme necessário para treinamento distribuído com facilidade. Ele está disponível em Python, Swift, C++ ou C, além de outras linguagens de sua escolha, graças às múltiplas ligações criadas pela comunidade de código aberto.

Além do MLX, se você estiver usando um dos frameworks populares de treinamento, como PyTorch e JAX, o Metal oferecerá suporte para que você explore novas fronteiras sem precisar abandonar as ferramentas amplamente adotadas pela comunidade de aprendizado de máquina. Por fim, o site developer.apple.com é um ótimo recurso para entusiastas e pesquisadores de IA conhecerem os novos recursos de aprendizado de máquina da Apple.

Com isso, concluímos nossa agenda. Vamos voltar um pouco e revisar tudo o que falamos hoje.

Com base em suas necessidades e experiência com modelos, você pode escolher as estruturas e ferramentas com o melhor suporte aos recursos de aprendizado de máquina e IA do seu projeto. Seja para ajustar um LLM no Mac, otimizar um modelo de visão computacional para implantar no Apple Vision Pro ou usar uma API com ML para adicionar recursos mágicos aos seus apps, nós temos algo para você. Tudo isso é otimizado para Apple Silicon, garantindo uma execução eficiente e poderosa para suas cargas de trabalho de aprendizado de máquina e IA.

Temos certeza de que você achará os recursos que analisamos aqui úteis e mal podemos esperar para descobrir as experiências que você criará com a Apple Intelligence. Nunca houve um momento melhor para experimentar e explorar o que você pode fazer com aprendizado de máquina e IA nas plataformas Apple. Aqui demos apenas uma pincelada no que é possível. Eu recomendo que você confira a categoria de ML e IA no app para desenvolvedores e em nossos fóruns para desenvolvedores para saber mais.

Faça perguntas e converse com a comunidade mais ampla de desenvolvedores.

Espero que isso tenha sido tão divertido para vocês quanto para mim. Agradeço sua participação.

-

-

- 0:00 - Introdução

A equipe de Aprendizado de Máquina no Dispositivo da Apple oferece ferramentas para fãs e desenvolvedores integrarem Apple Intelligence e aprendizado de máquina em apps e projetos pessoais. Saiba mais sobre inteligência de plataforma, frameworks de sistema, otimização de modelos e implantação, além de atualizar-se sobre as últimas inovações de ML e IA no hardware da Apple.

- 1:18 - Inteligência da plataforma

O aprendizado de máquina e a inteligência artificial estão no núcleo do nosso sistema operacional, potencializando vários recursos e apps integrados. Essas tecnologias propiciam experiências fluidas para o usuário, como autenticação segura, reconhecimento de manuscrito e redução de ruído durante chamadas. Ano passado, a inteligência generativa chegou ao núcleo do sistema operacional com as Ferramentas de Escrita, o Genmoji e o Image Playground. Esses recursos foram projetados para serem facilmente integrados aos apps existentes, permitindo que você aprimore suas interfaces com o mínimo de esforço. Uma ampla variedade de APIs baseadas em ML está disponível. Essas APIs fornecem acesso programático a modelos e recursos do sistema, permitindo tarefas como geração de imagens com o ImageCreator e sugestões de respostas inteligentes. A introdução do framework Foundation Models no iOS 26 simplifica ainda mais esse processo. Esse framework fornece acesso a um modelo de linguagem especializado para tarefas diárias e otimizado no dispositivo. Ele pode ser usado para sumarização, extração, classificação e muito mais, garantindo a privacidade dos dados do usuário, já que o modelo opera totalmente offline. Você pode solicitar o modelo, gerar respostas estruturadas e até mesmo integrá-lo com dados ao vivo ou pessoais usando chamadas de ferramentas, de modo que o modelo execute ações e cite fontes de verdade.

- 8:20 - APIs viabilizadas por ML

As APIs atualizadas com aprendizado de máquina oferecem um pacote completo de ferramentas para aprimorar a inteligência do app. Os frameworks incluem Vision para análise de imagens e vídeos, Natural Language para processamento de texto, Tradução para idiomas, Análise de Som para reconhecimento de sons e Fala para reconhecimento e transcrição. Entre as maiores novidades estão o reconhecimento de documentos e a detecção de manchas na lente no Vision, além da API SpeechAnalyzer, que permite processamento de fala para texto mais rápido e flexível, especialmente para áudio de formato longo e a distância. Os desenvolvedores também podem personalizar esses modelos usando app e framework CreateML.

- 11:15 - Modelos de ML

O Core ML simplifica o processo de integração de modelos de aprendizado de máquina em apps para dispositivos da Apple. Você pode utilizar modelos já no formato CoreML, disponíveis em developer.apple.com, e o espaço Apple no Hugging Face, ou converter modelos treinados de outros formatos usando as Ferramentas CoreML. O CoreML Tools otimiza esses modelos para execução no dispositivo, reduzindo o tamanho e melhorando o desempenho por meio de técnicas automáticas e manuais. Depois, é possível integrar facilmente esses modelos em Xcode, onde é possível inspecionar o desempenho, visualizar a arquitetura do modelo e gerar interfaces de Swift seguras para o tipo. Em tempo de execução, o CoreML potencializa a CPU, a GPU e o Neural Engine para uma execução eficiente. Para um controle mais avançado, combine modelos CoreML com MPSGraph, a computação do Metal ou a API BNNS Graph do Accelerate, que este ano ganhou novas capacidades, incluindo o BNNSGraphBuilder para tarefas de ML em tempo real baseadas em CPU.

- 14:54 - Exploração

O ritmo acelerado da pesquisa de aprendizado de máquina exige ferramentas e recursos sofisticados. O MLX da Apple, um framework de array de código aberto para computação numérica e aprendizado de máquina, foi projetado para aproveitar o poder do Apple Silicon. O MLX permite ajuste fino, treinamento e aprendizado distribuído de modelos avançados em dispositivos da Apple. Ele pode executar LLMs (grandes modelos de linguagem) com uma única chamada de linha de comando e aproveita a arquitetura de memória unificada do Apple Silicon, permitindo operações paralelas de CPU e GPU no mesmo buffer. Você pode acessar o MLX no Python, Swift, C++ e outras linguagens. Além disso, a Apple dá suporte a frameworks de treinamento populares, como PyTorch e Jax, por meio do Metal. O site developer.apple.com e os repositórios Apple Github são recursos valiosos para fãs e pesquisadores de IA, fornecendo acesso aos recursos de aprendizado de máquina mais recentes da Apple.