-

Découvrir les frameworks d’apprentissage automatique et d’IA sur les plates-formes Apple

Découvrez les dernières mises à jour des frameworks d'apprentissage automatique et d'IA disponibles sur les plates-formes Apple. Que vous soyez un développeur d'apps prêt à exploiter Apple Intelligence, un ingénieur en apprentissage automatique optimisant des modèles pour un déploiement sur appareil, ou un passionné d'IA explorant les limites possibles, nous vous guiderons pour choisir les outils les mieux adaptés à vos besoins.

Chapitres

- 0:00 - Introduction

- 1:18 - Intelligence des plates-formes

- 8:20 - API alimentées par le ML

- 11:15 - Modèles d’apprentissage automatique

- 14:54 - Exploration

Ressources

-

Rechercher dans cette vidéo…

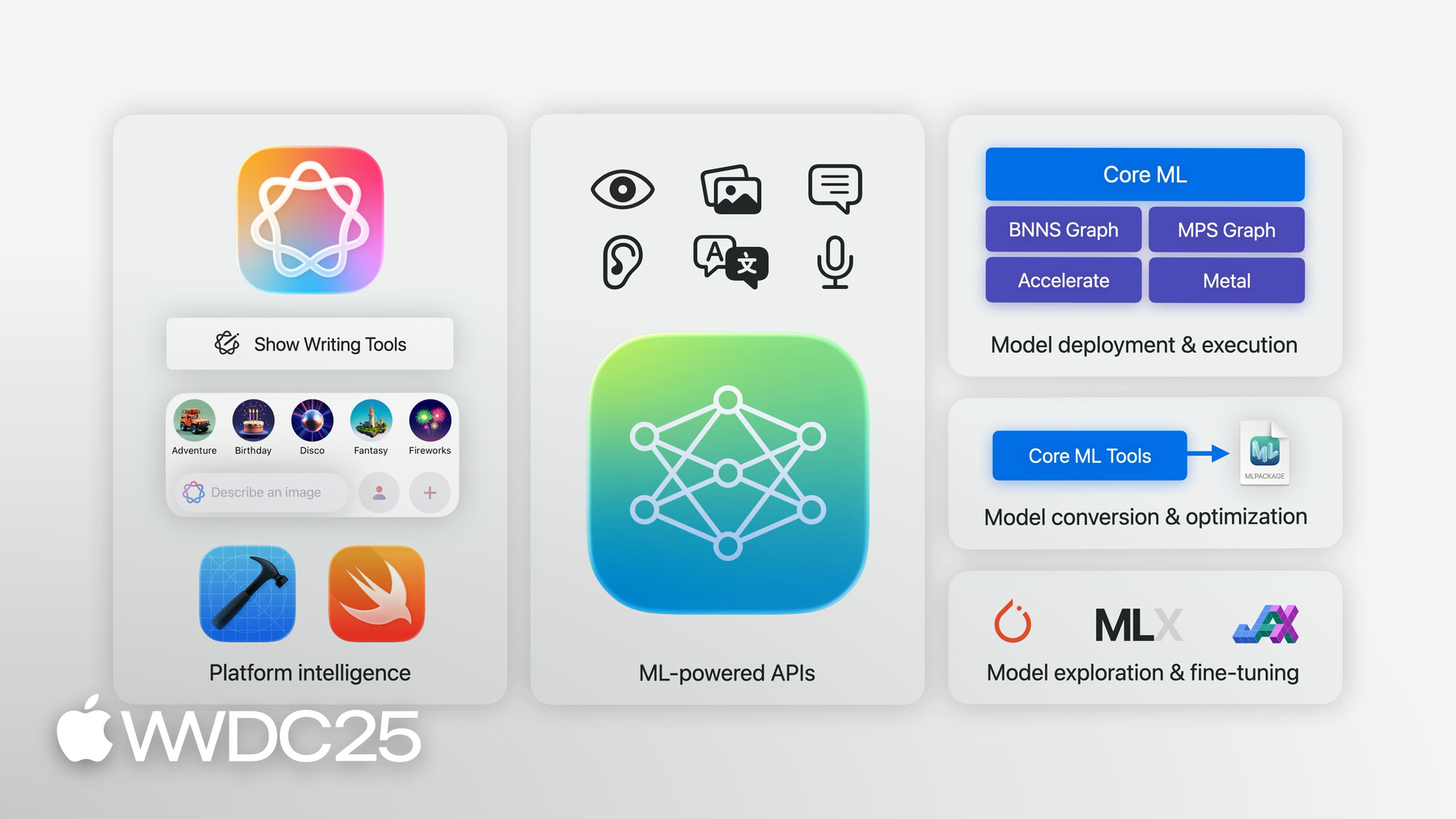

Bonjour, je m’appelle Jaimin Upadhyay, responsable ingénierie au sein de l’équipe Apprentissage automatique sur l’appareil chez Apple. Je vais vous parler d’Apple Intelligence et de l’apprentissage automatique dans vos apps et projets personnels. Que vous soyez un développeur d’apps qui utilise Apple Intelligence via des composants d’interface utilisateur ou dans le code, un ingénieur en apprentissage automatique (AA) qui optimise des modèles à déployer sur un appareil, ou un passionné d’IA qui explore les limites du possible sur votre Mac, nous avons les outils qu’il vous faut. Je vais vous présenter ces outils, les nouveautés et indiquer des ressources pour approfondir vos connaissances. Nous commencerons par un aperçu de l’intelligence intégrée au système d’exploitation et de sa relation avec votre app. Nous verrons comment utiliser cette intelligence de manière programmable avec nos system frameworks. Nous verrons ensuite comment les outils et API d’Apple peuvent optimiser et déployer les modèles d’apprentissage automatique afin de les exécuter sur un appareil. Enfin, nous expliquerons comment suivre les dernières innovations en matière d’AA et d’IA sur le matériel Apple.

Nous avons beaucoup de sujets à aborder. Commençons sans plus attendre. Nous commençons par l’intelligence de la plate-forme. L’apprentissage automatique et l’IA sont au cœur de nombreuses apps et fonctionnalités de notre système d’exploitation. Que ce soit pour l’authentification via Optic ID sur l’Apple Vision Pro, la reconnaissance de votre écriture pour vous aider à faire des maths sur iPad, ou la suppression des bruits de fond pour améliorer votre voix sur FaceTime, l’apprentissage automatique est incontournable. Les modèles d’AA derrière ces fonctionnalités ont été entraînés et optimisés pour être plus efficaces sur un appareil. L’année dernière a marqué un tournant avec l’intégration de l’intelligence générative dans nos systèmes d’exploitation, grâce à de grands modèles de base soutenant Apple Intelligence. Les outils d’écriture, Genmoji et Image Playground sont désormais intégrés au système, ce qui facilite leur utilisation dans vos apps. Si vous utilisez les commandes de texte système, vous pourrez utiliser automatiquement Genmoji. Vous pouvez même utiliser les API pour les afficher directement dans votre texte. Le framework Image Playground fournit des extensions SwiftUI pour afficher l’imagePlaygroundSheet dans votre app. Et, pour la plupart d’entre vous qui utilisez les frameworks d’interface utilisateur standard pour afficher les textViews, vos apps sont déjà configurées pour prendre en charge les outils d’écriture. C’est aussi simple que ça. Vous pouvez utiliser des vues standard ou ajouter quelques lignes de code à vos vues personnalisées. Vos utilisateurs peuvent donc accéder à Apple Intelligence dans vos apps via une interface cohérente et familière. Mais, que faire si vous ne voulez pas utiliser l’interface standard ou pour obtenir plus de contrôle ? Vous pouvez utiliser des API optimisées par l’AA qui vous donnent un accès programmatique aux modèles et fonctionnalités du système. Nous avons à cette fin de nombreuses API. Certaines d’entre elles offrent des modèles système majeurs avec des utilitaires essentiels, tandis que d’autres sont des API dédiées aux tâches d’AA spécifiques. Voyons comment vous pouvez intégrer la génération d’images dans votre app. iOS 18.4 a ajouté la classe ImageCreator dans le framework ImagePlayground. Elle vous permet de créer des images par programmation. Il vous suffit d’instancier le créateur d’image. Puis, créez des images à partir de quelques idées. Ici, nous utilisons une invite textuelle et un style sélectionné. Ensuite, vous pouvez les afficher ou les utiliser dans votre app selon vos besoins. Toujours dans la version 18.4, nous avons intégré l’API Smart Reply. Vous pouvez laisser vos utilisateurs choisir les réponses intelligentes générées pour leurs messages et e-mails, en donnant le contexte à un clavier. Voyons rapidement comment vous pouvez configurer cette fonctionnalité. Pour fournir votre conversation, configurez un UIMessage ou UIMailConversationContext avec vos données, puis définissez-le sur votre vue d’entrée avant que le clavier ne soit demandé. Lorsqu’un utilisateur sélectionne une réponse intelligente à partir du clavier pour un message instantané, celle-ci est directement insérée dans le document. Cependant, dans une conversation par e-mail, la sélection sera plutôt déléguée à la méthode insertInputSuggestion correspondante de votre vue. Vous pouvez ensuite générer et insérer vos propres réponses plus longues appropriées pour un e-mail. Pour en savoir plus, consultez la page de documentation « Adopting Smart Reply in your messaging or email app ». Tout cela s’exécute sur l’appareil et utilise les modèles de base d’Apple. Dans iOS 26, nous allons encore plus loin avec l’introduction du framework de Foundation Models. Il donne accès par programmation à un modèle de langage sur l’appareil hautement optimisé, dédié aux tâches quotidiennes. Il peut aussi intégrer ces fonctionnalités dans toutes vos apps. Ce framework est idéal pour la synthèse, l’extraction, la classification, etc. Vous pouvez l’utiliser pour améliorer des fonctionnalités existantes dans vos apps, comme les suggestions de recherche personnalisées. Vous pouvez créer de nouvelles fonctionnalités, comme générer un itinéraire dans une app de voyage.

Vous pouvez l’utiliser pour créer des dialogues instantanés pour les personnages d’un jeu. C’est ma fonctionnalité préférée !

Il suffit de trois lignes de code pour lancer le modèle. Importez le framework, créez une session et envoyez votre invite au modèle. Le framework étant intégré à l’appareil, les données utilisateurs restent confidentielles et ne nécessitent aucun transfert externe. Les fonctionnalités d’IA sont facilement disponibles et fonctionnent hors ligne. Nul besoin de créer un compte ou d’obtenir des clés API. Et tout cela, sans frais pour vous ou vos utilisateurs, quelle que soit la requête. Le framework de Foundation Models offre bien plus qu’une simple invite pour les réponses textuelles. Parfois, vous avez besoin d’un LLM pour générer des réponses structurées que vous pouvez utiliser directement dans votre app. C’est facile avec le framework de Foundation Models. Vous pouvez prendre des types existants dans votre app et les marquer comme Generable. Ajoutez également des guides en langage naturel à chaque propriété, ainsi que des contrôles facultatifs sur leurs valeurs générées. Vous pouvez ainsi utiliser la génération guidée sur une simple invite. Lorsque vous indiquez la réponse pour générer votre type.

Le framework personnalisera la boucle de décodage du modèle de langage et empêchera le modèle de faire des erreurs structurelles. Votre structure de données est remplie d’informations correctes, vous n’avez donc pas à vous occuper des schémas JSON. Concentrez-vous simplement sur l’invite et laissez le framework faire le reste ! La synergie entre Swift, le framework et vos types personnalisés vous permet d’itérer et d’explorer rapidement de nouvelles idées au sein de votre app.

Selon votre cas d’utilisation, vous devez prendre en compte les connaissances dont dispose le modèle de base. Outre les informations de votre invite et les descriptions génériques, le modèle possède des connaissances de base issues de ses données d’entraînement. Ces données sont figées dans le temps et n’incluent pas d’événements récents. Ce modèle est très puissant pour un appareil, mais il ne possède pas les mêmes connaissances que les modèles utilisés sur des serveurs. Pour les cas nécessitant des connaissances supplémentaires de votre app ou du réseau, le framework Foundation Models permet l’appel d’outils. L’appel d’outils vous permet d’aller au-delà de la génération de texte et d’effectuer certaines actions. Il permet au modèle d’accéder à des données en temps réel, telles que la météo et les événements du calendrier, et pas seulement aux données utilisées pour effectuer son entraînement. Il peut même laisser le modèle citer des sources de vérité, ce qui permet aux utilisateurs de vérifier ses résultats. Enfin, les outils peuvent effectuer des actions réelles, que ce soit dans votre app, sur le système ou dans le monde réel.

Ce n’était qu’un aperçu des fonctionnalités impressionnantes du framework, mais il y en a d’autres. Pour plus de détails, regardez « Meet the Foundation Models framework ». Vous y découvrirez les réponses en streaming, les sessions avec état et l’intégration étroite du framework avec Xcode. Si vous préférez apprendre par la pratique, nous proposons une séance de code pour développer votre première app intelligente avec les nouvelles API. Nous avons aussi une séance dédiée aux considérations de conception pour vos cas d’utilisation. Elle met l’accent sur les meilleures pratiques pour rédiger des invites de réflexion, sur les enjeux de sécurité liés à l’IA, sur la compréhension des capacités d’un modèle de langage intégré à l’appareil, ainsi que sur les stratégies d’évaluation et de test en matière de qualité et de sécurité. Consultez « Explore prompt design and safety for on-device Foundation models » pour en savoir plus.

Le nouveau framework de Foundation Models s’ajoute aux API et outils d’apprentissage automatique pour profiter de l’intelligence sur l’appareil dans les fonctionnalités de votre app. Ces frameworks ciblent chacun un domaine avec des modèles optimisés pour des tâches spécifiques. Nous avons Vision pour comprendre le contenu des images et des vidéos. Natural Language pour identifier le langage, les parties du discours et les entités nommées dans le texte en langage naturel. Translation pour effectuer des traductions dans plusieurs langues. Sound Analysis pour analyser et reconnaître de nombreux sons. Et Speech pour identifier et transcrire les mots prononcés d’un contenu audio. Le tout accessible en quelques lignes de code. Permettez-moi de souligner quelques nouveautés apportées à ces frameworks cette année.

Commençons par Vision. Vision possède plus de 30 API pour différents types d’analyse d’images. Aujourd’hui, Vision comporte deux nouvelles API. Vision apporte des améliorations pour la reconnaissance textuelle. Au lieu de lire des lignes de texte, Vision permet la reconnaissance des documents. Il peut regrouper différentes structures de documents, ce qui facilite le traitement et la compréhension des documents.

Vision intègre un nouveau mode de détection des traces sur les objectifs. Il permet d’identifier les traces sur l’objectif de l’appareil photo qui peuvent gâcher les images. Pour plus d’infos sur la détection des traces sur l’objectif et les autres fonctionnalités intéressantes de Vision, regardez « Reading documents using the Vision Framework ».

Ensuite, parlons du framework Speech. La classe SFSpeechRecognizer du framework Speech a permis d’accéder au modèle de synthèse vocale de Siri et a bien fonctionné pour la dictée courte. Dans iOS 26, nous introduisons une nouvelle API, SpeechAnalyzer, conçue pour répondre à de nombreux cas d’utilisation tout en tirant parti de la puissance de Swift. Cette API permet d’effectuer des opérations de synthèse vocale avec très peu de code, directement sur l’appareil.

Elle s’accompagne d’un nouveau modèle de synthèse vocale, plus rapide et plus flexible que son prédécesseur.

L’analyseur reçoit les tampons audio, les transmet au nouveau modèle de reconnaissance vocale, puis renvoie à l’app le texte correspondant à la voix enregistrée. Ce modèle est idéal pour les contenus audio longs ou à distance, comme les conférences, les réunions ou les conversations. Pour en savoir plus, regardez « Bring advanced speech-to-text to your app with SpeechAnalyzer ».

Les API Apple optimisées par l’AA offrent de nombreuses fonctionnalités dont votre app peut profiter facilement ! Plusieurs d’entre elles peuvent être adaptées ou étendues selon vos besoins spécifiques.

Grâce à l’app et au framework Create ML, vous pouvez optimiser les modèles système avec vos propres données. Créez un classificateur d’images à utiliser avec Vision, ou définissez un marqueur de mots personnalisé pour Langage naturel. Vous pouvez même étendre les fonctionnalités de Vision Pro pour reconnaître et suivre des objets spécifiques avec 6 degrés de liberté pour des expériences spatiales enrichies.

Nous avons abordé la manière dont vous pouvez tirer parti des fonctionnalités d’IA et d’AA intégrées au système ou les étendre. Passons à l’intégration d’un modèle sur l’appareil. Avant d’ajouter un modèle à votre app, vous devez évaluer plusieurs éléments. Core ML simplifie ce processus. Un modèle au format Core ML est tout ce qu’il vous faut. Ce format décrit les entrées, les sorties, l’architecture et les paramètres d’entraînement.

Sur developer.apple.com, vous trouverez une large sélection de modèles Core ML,

classés par catégories, avec les fonctionnalités détaillées de chaque modèle, leurs variantes et leurs performances sur les appareils.

Nous vous conseillons aussi de consulter l’espace Apple sur Hugging Face, qui propose des modèles Core ML accompagnés de liens vers leur définition source.

Ces définitions, souvent disponibles dans PyTorch, incluent des pipelines d’entraînement et d’optimisation.

Core ML Tools fournit tous les outils nécessaires pour convertir vos modèles entraînés au format Core ML. Les conversions intègrent des optimisations pour une exécution efficace sur l’appareil, comme la fusion d’opérations ou l’élimination de calculs inutiles. Cependant, coremltools propose d’autres techniques de compression de modèles pour les opérations d’optimisation et de post-entraînement. Vous pourrez ainsi réduire la taille de votre modèle et améliorer ses performances d’inférence en termes de mémoire, de puissance et de latence.

Ces techniques sont facultatives et permettent d’explorer divers compromis entre les performances et la précision du modèle.

Pour en savoir plus, regardez la séance « Bring your models to Apple Silicon » de la WWDC24. Consultez les dernières notes de mise à jour et les exemples fournis dans le guide d’utilisation.

Une fois que votre modèle est au format Core ML, vous pouvez facilement l’intégrer à Xcode. Vous pouvez inspecter les principales caractéristiques de votre modèle ou analyser ses performances sur un appareil connecté. Vous pouvez obtenir des informations sur la latence de prédiction, les temps de chargement, mais aussi sur l’endroit où une opération particulière est prise en charge et exécutée, directement dans Xcode. Nouveauté cette année : vous pouvez visualiser la structure complète de l’architecture du modèle et examiner en détail chaque opération. Cette nouvelle vue vous offre une meilleure compréhension du modèle que vous utilisez. Vous découvrirez ainsi les opportunités de débogage et d’amélioration des performances très rapidement.

Dès que vous êtes prêt à coder, Xcode génère automatiquement une interface Swift sécurisée, spécifique à votre modèle. L’intégration ne nécessite que quelques lignes de code.

À l’exécution, Core ML exploite toutes les ressources disponibles : CPU, GPU, and Neural engine.

Bien que Core ML soit la référence pour le déploiement sur l’appareil, certains scénarios exigent un contrôle plus poussé. Par exemple, si vous devez intégrer l’apprentissage automatique à un flux graphique, utilisez vos modèles Core ML avec MPS Graph et Metal. Par ailleurs, lorsque vous effectuez un traitement des signaux en temps réel sur le processeur, l’API BNNS Graph d’Accelerate offre un contrôle précis sur la latence et la gestion de la mémoire pour votre tâche d’AA.

Ces frameworks font partie intégrante de Core ML et sont également directement accessibles.

Cette année, BNNSGraph propose de nouvelles fonctionnalités, notamment un nouveau générateur de graphiques qui permet aux développeurs de créer des graphiques d’opérations. Vous pouvez donc écrire des routines de prétraitement et de post-traitement, voire de petits modèles d’apprentissage automatique, qui s’exécuteront en temps réel sur le processeur. Regardez « What’s new in BNNS Graph » pour en savoir plus.

Enfin, discutons de la manière dont vous pouvez suivre le rythme effréné des avancées de l’apprentissage automatique et comment la plate-forme Apple peut vous aider. La recherche en AA évolue à un rythme soutenu, avec des avancées quotidiennes. De nouveaux modèles et techniques sont actuellement étudiés et développés à un rythme sans précédent. Il y a beaucoup de choses à tester et à explorer, ce qui peut être difficile sans les outils et les ressources adéquats. Pour rester à la pointe de la recherche, vous devez pouvoir exécuter des modèles de grande taille, tester des architectures originales et évoluer au sein d’une communauté ouverte. Nous mettons à votre disposition des outils et des ressources avancés pour vous accompagner dans ce parcours. MLX est l’un de ces puissants outils.

C’est un framework de traitement d’arrays pour le calcul numérique et l’apprentissage automatique. Il a été conçu par les chercheurs d’Apple et entièrement développé en open source. MLX donne accès à des modèles de pointe et permet un réglage fin, un entraînement efficace ainsi qu’un apprentissage distribué sur les machines dotées d’une puce Apple.

MLX peut exécuter des inférences avancées en apprentissage automatique sur de grands modèles de langage comme Mistral, avec une simple ligne de commande. Par exemple, ici, il génère du code pour le tri rapide avec une longueur de jeton maximale de 1024.

Vous restez ainsi à la pointe de la recherche, grâce à la communauté open source qui s’efforce de rendre ces modèles compatibles avec MLX.

La communauté MLX sur Hugging Face propose des centaines de modèles de pointe accessibles avec une simple ligne de code. Regardez « Explore large language models on Apple silicon with MLX » pour découvrir comment exécuter Deep-Sea Car 1 sur votre machine équipée d’une puce Apple.

MLX est conçu pour exploiter au mieux les capacités de la puce Apple. Cela inclut un nouveau modèle de programmation spécifique à la mémoire unifiée.

La majorité des systèmes d’apprentissage automatique utilisent un processeur graphique dédié, doté de sa propre mémoire. Les données sont souvent locales et liées à un appareil spécifique. Les opérations s’exécutent là où se trouvent les données. Vous ne pouvez pas exécuter efficacement des opérations qui utilisent des données provenant de plusieurs pools de mémoire. En effet, celles-ci nécessitent une copie en mémoire. La puce Apple, quant à elle, possède une architecture mémoire unifiée. Cela signifie que le CPU et le GPU partagent la même mémoire physique. Dans MLX, les arrays ne sont pas liés à un appareil, mais les opérations le sont, ce qui permet d’exécuter différentes opérations sur le processeur principal et le processeur graphique en parallèle sur le même tampon.

Regardez « Get started with MLX for Apple silicon » pour découvrir ce modèle de programmation unique et les autres fonctionnalités de MLX. Vous pouvez affiner vos modèles avec une ligne de code et les faire évoluer selon vos besoins, y compris pour l’apprentissage distribué.

MLX est disponible en Python, Swift, C++ ou C et dans d’autres langages grâce aux liaisons créées par la communauté open source.

En plus de MLX, si vous utilisez l’un des frameworks d’entraînement populaires, tels que PyTorch et Jax, nous proposons Metal, qui vous permettra d’accéder aux dernières avancées sans quitter les outils standard adoptés par la communauté AA depuis longtemps. Developer.apple.com reste une excellente ressource pour tous les développeurs en IA qui souhaitent découvrir les dernières ressources d’Apple en matière d’apprentissage automatique.

Ceci conclut notre ordre du jour. Prenons un peu de recul et revenons sur ce dont nous avons parlé aujourd’hui.

En fonction de vos besoins et de votre expérience avec les modèles, vous pouvez choisir les frameworks et les outils qui correspondent le mieux aux fonctionnalités de votre projet en matière d’apprentissage automatique et d’IA. Que vous vouliez optimiser un LLM sur votre Mac, optimiser un modèle de vision par ordinateur pour Apple Vision Pro ou utiliser nos API basées sur l’AA pour enrichir vos apps avec des fonctionnalités extraordinaires, nous avons ce qu’il vous faut. Tout est conçu pour tirer le meilleur parti de la puce Apple, avec des performances optimales pour vos tâches en apprentissage automatique et en IA.

Nous sommes convaincus que les ressources présentées ici vous seront utiles. Nous sommes impatients de découvrir les nouvelles expériences que vous créerez grâce à Apple Intelligence. C’est le moment idéal pour expérimenter, créer et innover grâce à l’apprentissage automatique et à l’IA sur les plates-formes Apple. Tout ceci n’est qu’un aperçu des possibilités. Pour aller plus loin, consultez la catégorie Apprentissage automatique et IA dans l’app Apple Developer et rejoignez les discussions sur nos forums.

Posez des questions et discutez avec la communauté des développeurs.

J’espère que vous avez apprécié cette session. Merci de votre attention !

-

-

- 0:00 - Introduction

L’équipe On-Device Machine Learning d’Apple propose des outils aux développeurs et aux passionnés pour intégrer Apple Intelligence et l’apprentissage automatique dans leurs apps et leurs projets personnels. Apprenez-en davantage sur l’intelligence des plateformes, les system frameworks, l’optimisation et le déploiement des modèles, et restez informé des dernières innovations en matière d’apprentissage automatique et d’IA sur les équipements Apple.

- 1:18 - Intelligence des plates-formes

L’apprentissage automatique et l’intelligence artificielle sont au cœur de notre système d’exploitation et optimisent diverses apps et fonctionnalités intégrées. Ces technologies offrent une expérience utilisateur fluide, notamment grâce à une authentification sécurisée, la reconnaissance de l’écriture manuscrite et la réduction du bruit pendant les appels. L’année dernière, l’intelligence générative a été intégrée au cœur de notre système d’exploitation avec les outils d’écriture, Genmoji et Image Playground. Ces fonctionnalités sont conçues pour être aisément intégrées aux apps existantes, ce qui vous permet d’améliorer vos UI avec un minimum d’effort. Une vaste gamme d’API basées sur l’apprentissage automatique est disponible. Ces API offrent un accès programmatique aux modèles et fonctionnalités du système, permettant ainsi d’effectuer des tâches telles que la génération d’images avec ImageCreator et de proposer des suggestions de réponses intelligentes. L’introduction du framework de Foundation Models dans iOS 26 simplifie encore davantage ce processus. Ce framework permet d’accéder à un modèle de langage hautement optimisé sur appareil, spécialisé dans les tâches quotidiennes. Il peut être utilisé pour la synthèse, l’extraction, la classification des contenus et bien plus encore, tout en garantissant la confidentialité des données des utilisateurs, car le modèle fonctionne entièrement hors ligne. Vous pouvez aisément interagir avec le modèle, générer des réponses structurées et même l’intégrer à des données en direct ou personnelles à l’aide d’outils d’appel, ce qui permet au modèle d’effectuer des actions et de citer des sources fiables.

- 8:20 - API alimentées par le ML

Les API optimisées par l’apprentissage automatique vous offrent une suite complète d’outils qui rendent vos apps plus intelligentes. Ces frameworks comprennent Vision pour l’analyse d’images et de vidéos, Langage naturel pour le traitement de texte, Traduction pour les langues, Analyse sonore pour la reconnaissance des sons et Parole pour la reconnaissance et la transcription. Parmi les nouveautés les plus remarquables, citons la reconnaissance de documents et la détection des traces sur l’objectif dans Vision, ainsi que l’API SpeechAnalyzer dans Parole, qui permet un traitement plus rapide et plus flexible de la reconnaissance automatique de la parole, en particulier pour les enregistrements audio longs ou avec un son lointain. Les développeurs peuvent également personnaliser ces modèles à l’aide de l’app et du framework CreateML.

- 11:15 - Modèles d’apprentissage automatique

Core ML simplifie le processus d’intégration des modèles d’apprentissage automatique dans les apps pour les appareils Apple. Vous pouvez utiliser des modèles déjà au format CoreML, disponibles sur developer.apple.com et dans l’espace Apple sur Hugging Face, ou convertir des modèles entraînés à partir d’autres formats à l’aide des outils CoreML. CoreML Tools optimise ces modèles pour une exécution sur l’appareil, en réduisant leur taille et en améliorant leurs performances grâce à des techniques automatiques et manuelles. Vous pouvez ensuite intégrer facilement ces modèles dans Xcode, où vous pouvez inspecter les performances, visualiser l’architecture du modèle et générer des interfaces Swift sécurisées. Lors de l’exécution, CoreML exploite le processeur, le GPU et le Neural Engine pour assurer une exécution efficace. Pour un contrôle plus avancé, combinez les modèles CoreML avec MPSGraph, Metal ou l’API BNNS Graph d’Accelerate, qui dispose de nouvelles fonctionnalités cette année, notamment un BNNSGraphBuilder pour les tâches d’apprentissage automatique en temps réel basées sur le processeur.

- 14:54 - Exploration

Compte tenu du rythme effréné de la recherche dans le domaine de l’apprentissage automatique, il est essentiel de s’équiper d’outils et de ressources sophistiqués pour rester à la pointe. MLX d’Apple, un framework open source pour le calcul numérique et l’apprentissage automatique, est conçu pour exploiter toute la puissance de la puce Apple. MLX permet un réglage, un entraînement et un apprentissage distribué efficaces des modèles de pointe sur les appareils Apple. Il est capable d’exécuter de grands modèles de langage à l’aide d’un seul appel de ligne de commande et tire parti de l’architecture de mémoire unifiée de la puce Apple, permettant des opérations parallèles du processeur et du GPU sur la même mémoire tampon. Vous pouvez accéder à MLX en Python, Swift, C++ et d’autres langages. De plus, Apple prend en charge les frameworks d’entraînement populaires, tels que PyTorch et Jax via Metal. Le site web developer.apple.com et les référentiels Github d’Apple constituent des ressources précieuses pour les passionnés et les chercheurs en IA, car ils donnent accès aux dernières ressources d’Apple en matière d’apprentissage automatique.