-

Descubre las estructuras de aprendizaje automático e IA en las plataformas de Apple

Te daremos un recorrido por las actualizaciones de aprendizaje automático y estructuras de IA. Tanto si eres un desarrollador que quiere aprovechar Apple Intelligence, como si eres un ingeniero de aprendizaje automático que optimiza modelos para su implementación, o un entusiasta de la IA que explora las posibilidades, ofrecemos asesoría sobre las herramientas adecuadas.

Capítulos

- 0:00 - Introducción

- 1:18 - Inteligencia de plataforma

- 8:20 - API impulsadas por aprendizaje automático

- 11:15 - Modelos de aprendizaje automático

- 14:54 - Exploración

Recursos

-

Buscar este video…

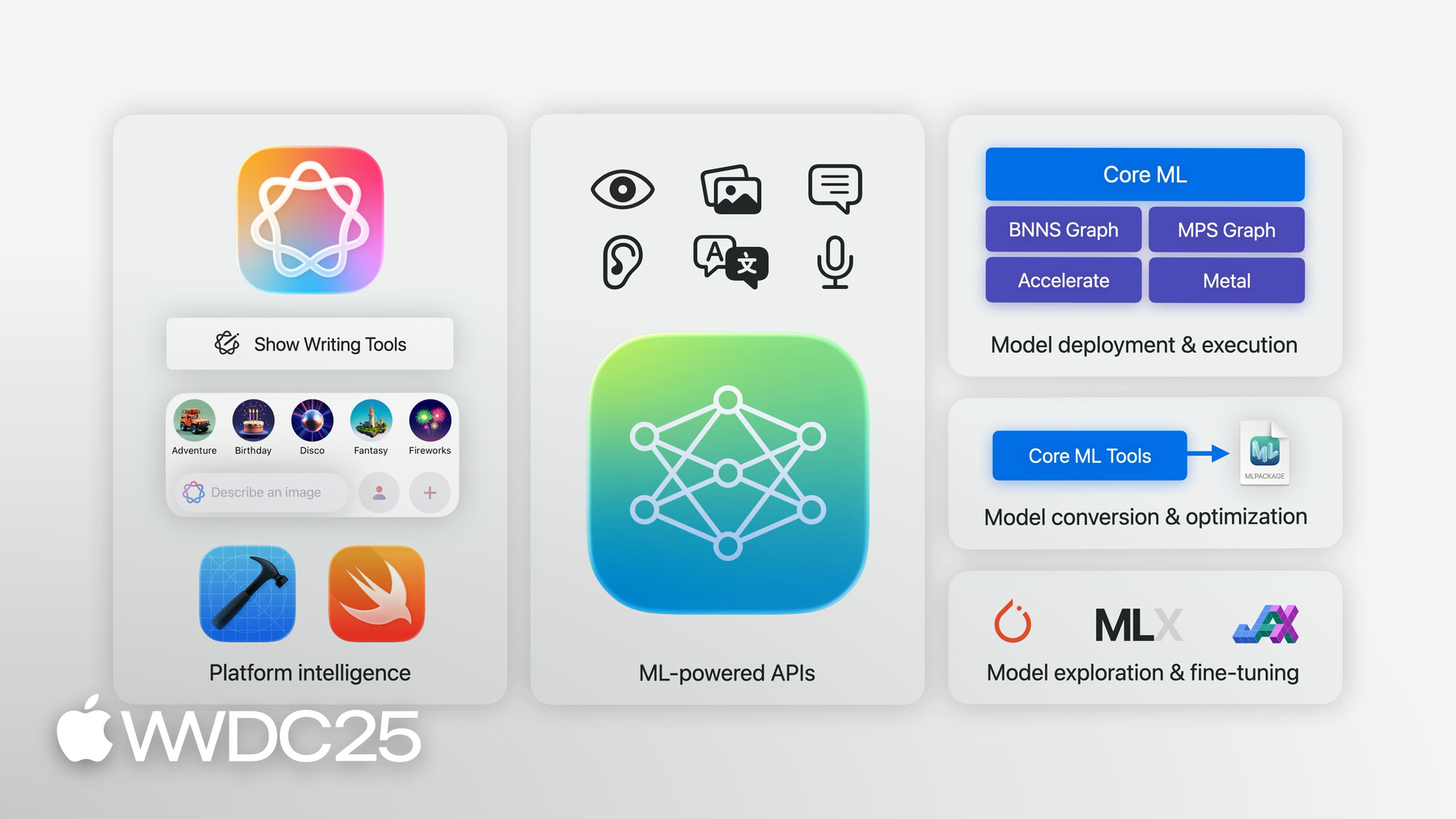

Hola, soy Jaimin Upadhyay, gerente de ingeniería del equipo de aprendizaje automático en el dispositivo de Apple. Hoy me gustaría hablar de cómo puedes usar Apple Intelligence y el aprendizaje automático en tus apps y proyectos personales. Tanto si eres un desarrollador de apps que quiere aprovechar Apple Intelligence a través de componentes de la interfaz de usuario o directamente en el código, como si eres un ingeniero de aprendizaje automático que convierte y optimiza modelos para su implementación en el dispositivo, o un entusiasta de la IA que explora las posibilidades en la Mac, tenemos las herramientas. Te guiaré a través de una descripción general de alto nivel de estas herramientas, destacaré las últimas incorporaciones y te indicaré recursos para aprender más por el camino. Empezaremos con una descripción general de la inteligencia integrada en el sistema operativo y su relación con tu app. Luego exploraremos cómo aprovechar programáticamente esta inteligencia a través de nuestras estructuras del sistema. Hablaremos de cómo las herramientas y API de Apple pueden ayudarte a optimizar e implementar modelos de aprendizaje automático en el dispositivo. Por último, hablaremos de cómo mantenerse al día de las últimas innovaciones en aprendizaje automático e IA en el hardware de Apple.

Tenemos un largo y emocionante recorrido que cubrir, así que empecemos. Empezamos con la inteligencia de las plataformas. El aprendizaje automático y la inteligencia artificial son la base de muchas apps y funcionalidades integradas en nuestro sistema operativo. Ya sea Optic ID para autenticarte en el Apple Vision Pro, o entender tu escritura para ayudarte con las matemáticas en el iPad, o eliminar el ruido de fondo para mejorar la calidad de la voz en FaceTime, el aprendizaje automático es la base. Los modelos de aprendizaje automático que impulsan estas funcionalidades se entrenaron y optimizaron para lograr una mayor eficiencia en el dispositivo, y el año pasado marcó el inicio de un nuevo capítulo, para llevar la inteligencia generativa al núcleo de nuestros sistemas operativos, con grandes modelos fundacionales que impulsan Apple Intelligence. De este modo, Herramientas de Escritura, Genmoji e Image Playground pasaron a formar parte del sistema, lo que facilita su integración en tus apps. Si usas los controles de texto del sistema, Genmoji será compatible automáticamente. Incluso puedes usar las API para que aparezcan directamente en el texto. La estructura Image Playground proporciona extensiones de interfaz de usuario de Swift para que aparezca imagePlaygroundSheet en la app. Además, para los que usan las estructuras de IU estándar para mostrar textViews, las apps estaban configuradas para Herramientas de Escritura. Es así de simple. Puedes usar vistas estándar o agregar algunas líneas de código a las vistas personalizadas. De este modo, los usuarios pueden acceder fácilmente a Apple Intelligence dentro de tus apps con una interfaz de usuario uniforme y familiar. ¿Y si quieres ir más allá de la interfaz de usuario predeterminada o necesitas más control? Esto nos lleva al tema de las API con tecnología de aprendizaje automático que ofrecen acceso programático a los modelos y capacidades del sistema. Ofrecemos una amplia variedad de estas API. Mientras que algunas permiten acceder a modelos de sistemas destacados con utilidades esenciales, otras exponen API prácticas para tareas de aprendizaje automático especializadas. Veamos cómo integrar la generación de imágenes en tu app. Con iOS 18.4 se presentó la clase ImageCreator a la estructura ImagePlayground. Permite crear imágenes mediante programación. Solo hay que instanciar el creador de imágenes. Solicita imágenes a partir de algunas ideas. En este caso, usamos un prompt de texto y un estilo seleccionado. Después, puedes mostrarlos o usarlos en tu app como prefieras. También en 18.4 presentamos la API Smart Reply. Puedes dejar que los usuarios elijan respuestas inteligentes generadas para sus mensajes y correos electrónicos, donando el contexto a un teclado. Veamos cómo configurarlo. Para donar la conversación, configura un ConversationContext de UIMessage o UIMail con tus datos y, a continuación, establécelo en la vista de entrada antes de que se solicite el teclado. Cuando un usuario selecciona una respuesta inteligente del teclado para un mensaje instantáneo, se insertará directamente en el documento. Sin embargo, en una conversación de correo, la selección se remitirá al método delegado insertInputSuggestion correspondiente de la vista. A continuación, puedes generar e insertar tus propias respuestas más largas apropiadas. Para más información, consulta la página de documentación sobre la adopción de Smart Reply en tu app de mensajería o correo. Todo esto se ejecuta en el dispositivo y usa los modelos fundacionales. En iOS 26, vamos más allá con la presentación de: la estructura Foundation Models. Proporciona acceso programático a un modelo de lenguaje en el dispositivo altamente optimizado y especializado para las tareas cotidianas. Ahora puede potenciar estas funcionalidades en todas tus apps. Es ideal para resúmenes, extracciones, clasificaciones y mucho más. Puedes utilizarlo para mejorar funcionalidades existentes en tus apps, como ofrecer sugerencias de búsqueda personalizadas. O bien puedes crear funcionalidades completamente nuevas, como generar itinerarios en una app de viajes.

Puedes usarlo para crear diálogos para los personajes de un juego. Ese es mi favorito.

Enviar un prompt al modelo es tan fácil como tres líneas de código. Importa la estructura, crea una sesión y envía tu prompt al modelo. Como la estructura está en el dispositivo, los datos del usuario permanecen privados y no es necesario enviarlos a ninguna parte. Las funcionalidades de IA están disponibles de inmediato y funcionan sin conexión, por lo que no es necesario crear una cuenta ni obtener claves de API. Todo esto sin ningún costo para ti ni para los usuarios. La estructura Foundation Models ofrece mucho más que un simple prompt para las respuestas textuales. A veces necesitas un LLM para generar respuestas estructuradas que puedas usar directamente en la app. Esto es fácil con la estructura Foundation Models. Puedes seleccionar tipos existentes en tu app y marcarlos como generables. También agrega algunas guías de lenguaje natural a cada propiedad, junto con controles opcionales sobre los valores generados. Esto te permite usar Guided Generation con un prompt simple. A continuación, indica la respuesta para generar el tipo.

La estructura personalizará el bucle de descodificación del modelo lingüístico y evitará que el modelo cometa errores estructurales. Tu estructura de datos se rellena con la información correcta, por lo que no tienes que lidiar con esquemas JSON. Solo tienes que centrarte en el prompt y dejar que la estructura haga el resto. La sinergia entre Swift, la estructura y los tipos personalizados facilita la iteración rápida y la exploración de nuevas ideas dentro de la app.

Al desarrollar el caso de uso, es importante tener en cuenta los conocimientos disponibles para el modelo fundacional. Además de la información proporcionada a través del prompt y de las descripciones de tipos generables, el modelo dispone de un conjunto básico de conocimientos derivados de los datos con los que se entrenó. Estos datos se fijaron en el tiempo y no contienen acontecimientos recientes. Aunque el modelo es increíblemente potente para un modelo a escala de dispositivo, no tiene tantos conocimientos como los modelos a escala de servidor más grandes. Para los casos de uso que requieren conocimientos adicionales de la app o a través de la red, la estructura del modelo fundacional admite la llamada de herramientas. La llamada de herramientas te permite no solo generar texto, sino también realizar algunas acciones. Permite al modelo acceder a datos en directo o personales, como el tiempo y los eventos del calendario, y no solo a lo que se entrenó hace meses. Incluso puede permitir que el modelo cite fuentes de información veraz, lo que permite a los usuarios comprobar los resultados. Por último, las herramientas pueden realizar acciones reales, ya sea en la app, en el sistema o en el mundo real.

Esto es solo un anticipo de las increíbles capacidades de la estructura, pero hay mucho más. Para una introducción más detallada, consulta la sesión sobre la estructura Foundation Models. También aprenderás sobre las respuestas en streaming, las sesiones con control de estado y la estrecha integración de la estructura con Xcode. Y si prefieres aprender de forma práctica, tenemos una sesión de código para crear tu primera app inteligente utilizando las nuevas API. Tenemos una sesión sobre las consideraciones de diseño para tus casos. Se centra en las prácticas recomendadas para elaborar prompts reflexivos, consideraciones sobre la seguridad de la IA, la comprensión de las posibilidades de un modelo lingüístico a escala de dispositivo y algunas estrategias sólidas para evaluar y probar la calidad y la seguridad. Más información en la sección sobre diseño y seguridad de prompts para los modelos fundacionales.

La nueva estructura se suma al conjunto de otras API y herramientas basadas en aprendizaje automático que puedes usar para aprovechar la inteligencia para las funcionalidades de tu app. Cada una de estas estructuras se centra en un ámbito específico con modelos altamente optimizados para tareas concretas. Existe Vision para comprender el contenido de imágenes y videos. Natural Language para identificar el lenguaje, las partes del discurso y las entidades con nombre en un texto en lenguaje natural. Translation para realizar traducciones de texto entre varios idiomas. Sound Analysis para reconocer diversas categorías de sonido. Y Speech para identificar y transcribir palabras habladas en audio. Todo con solo unas líneas de código. Esta son novedades interesantes que se incorporan a estas estructuras.

Empecemos con Vision. Vision dispone de más de 30 API para distintos tipos de análisis de imágenes. Además, Vision incorpora hoy dos nuevas API. Vision presenta mejoras en el reconocimiento de textos. No solo se limita a leer líneas de texto: ofrece reconocimiento de documentos. Puede agrupar diferentes estructuras de documentos, lo que facilita su procesamiento y comprensión.

También cuenta con un modo de detección de manchas. Identifica las manchas en el lente que pueden arruinar las imágenes. Para obtener más información sobre Lens Smudge Detection y las demás novedades de Vision, consulta el artículo dedicado a la lectura de documentos con la estructura Vision.

A continuación, hablemos de la estructura Speech. La clase SFSpeechRecognizer de la estructura Speech te daba acceso al modelo de conversión de voz a texto de Siri y funcionaba bien para dictados cortos. Ahora, en iOS 26, presentamos una nueva API, SpeechAnalyzer, que admite muchos más casos de uso y aprovecha la potencia de Swift. La nueva API permite realizar el procesamiento de voz a texto con muy poco código completamente en el dispositivo.

Junto con la API, ofrecemos un nuevo modelo de voz a texto más rápido y flexible que el anterior.

Los búferes de audio se pasan al analizador, que los conduce a través del nuevo modelo de conversión de voz a texto. El modelo predice el texto que coincide con el audio y lo devuelve a la app. El nuevo modelo es ideal para audio de larga duración y a distancia, como conferencias, reuniones y conversaciones. Ve el video dedicado a la conversión avanzada de voz a texto en la app con SpeechAnalyzer para profundizar en el tema.

Las API de Apple basadas en el aprendizaje automático ofrecen numerosas posibilidades que tu app puede aprovechar fácilmente. Y muchas de estas API pueden ampliarse o personalizarse para tu caso de uso específico.

La app y la estructura Create ML te permiten ajustar los modelos del sistema con tus propios datos. Crea tu propio clasificador de imágenes para usarlo con la estructura Vision, o un etiquetador de palabras personalizado para usarlo con Natural Language. Incluso puedes ampliar las capacidades del Vision Pro para reconocer y seguir objetos específicos con 6 grados de libertad para experiencias espaciales.

Hasta ahora hablamos de cómo aprovechar o ampliar las capacidades de aprendizaje automático e IA integradas en el sistema. A continuación, hablemos de llevar cualquier modelo a un dispositivo. Al elegir e integrar un modelo en tu app, hay mucho que considerar. Pero Core ML lo hace más fácil. Todo lo que necesitas es un modelo en formato Core ML. Estos recursos del modelo contienen una descripción de las entradas, salidas y arquitectura del modelo junto con sus parámetros aprendidos.

En developer.apple.com puedes encontrar una gran variedad de modelos abiertos en formato Core ML listos para usar.

Están organizados por categorías, con una descripción de las capacidades de cada modelo y una lista de las distintas variantes, junto con información de alto nivel sobre el rendimiento de los distintos dispositivos.

Del mismo modo, puedes echar un vistazo al espacio de Apple en Hugging Face. Además de los modelos ya en formato Core ML, también encontrarás enlaces a la definición del modelo fuente.

Estas definiciones de modelos se expresan a menudo en PyTorch junto con procesos de entrenamiento y ajuste.

Core ML Tools ofrece utilidades y flujos de trabajo para transformar modelos entrenados al formato de modelos de Core ML. Estos flujos de trabajo no solo traducen directamente la representación, sino que aplican optimizaciones para la ejecución en el dispositivo. Algunas de estas optimizaciones son automáticas, como la fusión de operaciones y la eliminación de cálculos redundantes. Sin embargo, coremltools proporciona un conjunto de técnicas de compresión basadas en el ajuste preciso y el entrenamiento posterior. Esto te ayudará a reducir el tamaño del modelo y a mejorar su rendimiento de inferencia en términos de memoria, potencia y latencia.

Estas técnicas son opcionales y permiten explorar distintos equilibrios entre rendimiento y precisión del modelo.

Consulta la sesión sobre cómo llevar los modelos al chip de Apple de la WWDC24 para más información. Además, asegúrate de consultar las últimas notas de la versión y los ejemplos de la guía del usuario.

Una vez que tengas tu modelo en el formato Core ML, puedes integrarlo fácilmente con Xcode. Puedes inspeccionar las características clave del modelo o explorar su rendimiento en cualquier dispositivo conectado. Puedes obtener información sobre la latencia de predicción prevista, los tiempos de carga y, además, introspeccionar dónde se admite y ejecuta una operación concreta, directamente en Xcode. Como novedad este año, puedes visualizar la estructura de la arquitectura del modelo completo y profundizar en los detalles de cualquier operación. Esta nueva vista te ayuda a comprender mejor el modelo con el que estás trabajando, con lo que las oportunidades de depuración y rendimiento son increíblemente visibles.

Cuando llega el momento de codificar, Xcode genera una interfaz de tipo seguro en Swift específica para tu modelo. La integración es cuestión de unas líneas de código.

En tiempo de ejecución, Core ML aprovecha todas las capacidades de cálculo disponibles, optimizando la ejecución en el CPU, el GPU y Neural Engine.

Aunque Core ML es la estructura a la que se puede recurrir para implementar modelos en el dispositivo, existen situaciones en las que se necesita un control más preciso. Por ejemplo, si necesitas secuenciar o integrar aprendizaje automático con cargas de trabajo gráficas, puedes usar modelos de Core ML tanto con MPS Graph como con Metal. En cambio, cuando se ejecuta el procesamiento de señales en tiempo real en el CPU, la API BNNS Graph de Accelerate proporciona un control estricto de la latencia y la administración de la memoria para el aprendizaje automático.

Estas estructuras forman parte de los fundamentos de Core ML y también están disponibles directamente para ti.

Este año, BNNSGraph incorpora nuevas capacidades, como un nuevo Graph Builder que permite a los desarrolladores crear gráficos de operaciones. Así, puedes escribir rutinas previas y posteriores al procesamiento o pequeños modelos de aprendizaje automático para ejecutar en tiempo real. Consulta las novedades de BNNS Graph.

Por último, hablemos de cómo mantenerse al día con el desarrollo en el aprendizaje automático y cómo puede ayudarte la plataforma de Apple. La investigación sobre el aprendizaje automático avanza a un ritmo vertiginoso y cada día se producen nuevos avances. Se exploran y construyen nuevos modelos y técnicas a un ritmo sin precedentes. Hay mucho que hacer para mantenerse al día. Puede ser un desafío sin las herramientas y los recursos adecuados. Para mantenerse al día en la exploración actual, se necesita la capacidad de ejecutar grandes modelos, experimentar con arquitecturas únicas y aprender de una comunidad abierta. Disponemos de herramientas y recursos para ayudarte en tu empeño de explorar la frontera. Una de estas potentes herramientas es MLX.

Es una estructura para computación numérica y aprendizaje automático. Está diseñada por los investigadores de Apple y desarrollada en código abierto. MLX ofrece acceso a los modelos más avanzados y la posibilidad de realizar un ajuste preciso, un entrenamiento y un aprendizaje distribuido eficientes en las máquinas con chip de Apple.

Puede ejecutar la inferencia de aprendizaje automático avanzada en grandes modelos de lenguaje con una llamada a la línea de comandos. Por ejemplo, aquí está generando código para una clasificación rápida con una longitud máxima de token de 1024.

Esto te permite mantenerte a la vanguardia de la investigación, gracias a la comunidad de código abierto que trabaja para que estos modelos funcionen con MLX.

La comunidad de MLX en Hugging Face tiene cientos de modelos de frontera a tu disposición a través de una línea de código. Consulta la sesión sobre cómo explorar grandes modelos de lenguaje en el chip de Apple con MLX para saber cómo puedes ejecutar Deep-Sea Car 1 en tu máquina con chip de Apple.

MLX está diseñado para aprovechar lo mejor del chip de Apple. Esto incluye un nuevo modelo de programación para la memoria unificada.

Muchos sistemas usados para el aprendizaje automático tienen un GPU discreto con memoria independiente. Los datos suelen ser residentes y se vinculan a un dispositivo. Las operaciones se ejecutan con los datos. No puedes ejecutar eficientemente operaciones que utilicen datos de varios conjuntos. Necesitarían una copia en la memoria. El chip de Apple, en cambio, tiene una arquitectura de memoria unificada. Esto significa que el CPU y el GPU comparten la misma memoria física. Los arrays en MLX no están vinculados a un dispositivo, pero las operaciones sí, lo que permite incluso ejecutar diferentes operaciones en el CPU y el GPU en paralelo en el mismo buffer.

Consulta la sesión sobre cómo empezar a usar MLX para el chip de Apple y descubre este modelo de programación único y otras funcionalidades de MLX. Puedes ajustar el modelo con una sola línea de código y ampliarlo para un entrenamiento distribuido con facilidad.

Está disponible en Python, Swift, C++ o C, y otros lenguajes de tu elección a través de los numerosos bindings creados por la comunidad de código abierto.

Además de MLX, si usas una de las estructuras de entrenamiento más populares como PyTorch y Jax, te ofrecemos Metal, para que puedas explorar la frontera sin desviarte de las herramientas estándar que la comunidad de aprendizaje automático adoptó a lo largo de los años. Por último, developer.apple.com es un excelente recurso para que los entusiastas de la IA y los investigadores echen un vistazo a los últimos recursos de aprendizaje automático de Apple.

Con esto, cubrimos nuestra agenda. Retrocedamos un poco y echemos un vistazo a todo lo que hablamos hoy.

En función de tus necesidades y experiencia con modelos, puedes elegir las estructuras y herramientas que mejor se adapten a las capacidades de aprendizaje automático e IA de tu proyecto. Tanto si quieres ajustar un LLM en una Mac, optimizar un modelo de visión por computadora para desplegarlo en el Apple Vision Pro o usar una de nuestras API impulsadas por aprendizaje automático para agregar rápidamente funcionalidades mágicas a tus apps, tenemos todo. Y todo ello optimizado para el chip de Apple, que proporciona una ejecución eficiente y potente para tus cargas de trabajo de aprendizaje automático e IA.

Estamos seguros de que los recursos que repasamos aquí te resultarán útiles y esperamos impacientes las nuevas experiencias que crees aprovechando Apple Intelligence. Es el mejor momento para experimentar y explorar lo que se puede hacer con el aprendizaje automático y la IA en las plataformas. Solo cubrimos la superficie. Te animo a que consultes la categoría de aprendizaje automático e IA en la app para desarrolladores y en nuestros foros para desarrolladores para más información.

Haz preguntas y debate con la comunidad de desarrolladores en general.

Espero que te haya resultado tan divertido como a mí. ¡Gracias por unirte!

-

-

- 0:00 - Introducción

El equipo de On-Device Machine Learning de Apple ofrece herramientas para que los desarrolladores y entusiastas integren Apple Intelligence y el aprendizaje automático en apps y proyectos personales. Obtén más información sobre inteligencia de plataforma, estructuras de sistemas, optimización e implementación de modelos, y cómo estar actualizado sobre las innovaciones más recientes de ML e IA en hardware de Apple.

- 1:18 - Inteligencia de plataforma

El aprendizaje automático y la inteligencia artificial son la base de nuestro SO, y potencian varias apps y funcionalidades integradas. Estas tecnologías permiten experiencias de usuario fluidas, como la autenticación segura, reconocimiento de escritura a mano y reducción de ruido durante las llamadas. El año pasado incorporamos la inteligencia generativa al núcleo de nuestro sistema operativo con Herramientas de Escritura, Genmoji e Image Playground. Estas funcionalidades están diseñadas para integrarse fácilmente en apps existentes, para que puedas mejorar tus interfaces de usuario con el mínimo esfuerzo. Se encuentra disponible una amplia gama de API impulsadas por ML. Estas API ofrecen acceso programático a los modelos y capacidades del sistema, y así se habilitan tareas como la generación de imágenes con ImageCreator y sugerencias de respuestas inteligentes. La incorporación de la estructura Foundation Models en iOS 26 simplifica aún más este proceso. Proporciona acceso programático a un modelo de lenguaje en el dispositivo altamente optimizado y especializado para las tareas cotidianas. Puedes usarlo para resumir, extraer, clasificar, entre otras tareas, y al mismo tiempo garantizas la privacidad de los datos del usuario, ya que el modelo funciona completamente sin conexión. Puedes solicitar fácilmente el modelo, generar respuestas estructuradas e incluso integrarlo con datos en tiempo real o personales con llamadas a herramientas, lo que permite que el modelo realice acciones y cite fuentes de confianza.

- 8:20 - API impulsadas por aprendizaje automático

Las API actualizadas impulsadas por aprendizaje automático te ofrecen un conjunto integral de herramientas para mejorar la inteligencia de las app. Las estructuras incluyen Vision para el análisis de imágenes y videos, Natural Language para el procesamiento de texto, Translation para idiomas, Sound Analysis para reconocer sonidos y Speech para reconocimiento y transcripción. Algunas de las novedades destacadas son el reconocimiento de documentos y la detección de manchas en el lente en Vision, y la API SpeechAnalyzer en Speech, que permite un procesamiento de voz a texto más rápido y flexible, en particular para audio de formato largo y distante. Los desarrolladores también pueden personalizar estos modelos con la app y estructura CreateML.

- 11:15 - Modelos de aprendizaje automático

Core ML simplifica el proceso de integración de modelos de aprendizaje automático en apps para dispositivos Apple. Puedes usar modelos en formato CoreML, disponibles en developer.apple.com y en el espacio de Apple en Hugging Face, o convertir modelos entrenados desde otros formatos con las herramientas CoreML. CoreML Tools optimiza estos modelos para la ejecución en el dispositivo, reduce el tamaño y mejora el rendimiento con técnicas automáticas y manuales. Luego, puedes integrar fácilmente estos modelos en Xcode, donde puedes consultar el rendimiento, visualizar la arquitectura del modelo y generar interfaces Swift seguras para tipos. En tiempo de ejecución, CoreML aprovecha el CPU, el GPU y el Neural Engine para una ejecución eficiente. Para un control más avanzado, combina los modelos CoreML con MPSGraph, Metal Compute o la API BNNS Graph de Accelerate, con nuevas capacidades este año, entre ellas, un BNNSGraphBuilder para tareas de ML basadas en CPU en tiempo real.

- 14:54 - Exploración

El ritmo rápido de la investigación en aprendizaje automático exige herramientas y recursos sofisticados para estar actualizados. Apple MLX, una estructura de conjunto de código abierto para computación numérica y aprendizaje automático, está diseñado para aprovechar el poder de Apple Silicon. MLX permite el ajuste eficiente, el entrenamiento y el aprendizaje distribuido de modelos de última generación en dispositivos Apple. Ejecuta modelos de lenguaje grandes con una sola llamada de línea de comando y aprovecha la arquitectura de memoria unificada de Apple Silicon, lo que permite operaciones paralelas de CPU y GPU en el mismo búfer. Puedes acceder a MLX en Python, Swift, C++ y otros lenguajes. Además, Apple admite estructuras de aprendizaje populares, como PyTorch y Jax, a través de Metal. Los entusiastas e investigadores de IA cuentan con recursos valiosos, como el sitio web developer.apple.com y los repositorios Github de Apple, que brindan acceso a las fuentes de información más recientes de aprendizaje automático de Apple.