-

Appleプラットフォームでの機械学習の詳細

Appleプラットフォームにおける機械学習フレームワークについて概説します。MLモデルを初めて実装する場合でも、すでにMLに精通している場合でも、アプリのニーズを満たす適切なフレームワークを選択する際に役立つ情報が得られます。

関連する章

- 0:00 - Introduction

- 2:05 - Apple Intelligence

- 3:55 - ML-powered APIs

- 7:16 - Running models on device

- 14:45 - Research

リソース

-

このビデオを検索

On Device Machine Learning Teamの Anil Kattiです 本日は Appleプラットフォームで利用できる 機械学習製品とサービスを紹介します 内容は多岐にわたりますが 順に見ていきましょう

AppleのOSとアプリの数々の革新的な機能の 基盤は高度な機械学習モデルとAIモデルです 空間コンピューティングでのジェスチャ認識 イメージキャプチャのポートレートモードや ヘルスケアでの心電図や 心拍数計測などがその例です これらの機能はすべて機械学習とAIによって 実現されておりこれらの機能の基盤となる モデルは完全にオンデバイスで実行されます そのためー 高度にインタラクティブな体験を実現しつつ ユーザーデータをデバイス内に保管して プライバシー保護を強化できます パワフルな Appleシリコンがオンデバイスの 機械学習を可能にしています ユニファイドメモリに CPU GPUおよびNeural EngineのMLアクセラレータを組み合わせて 低レイテンシーで高効率の推論を実現しています 本ビデオでは強力な Appleハードウェアと Appleならではの効率的なソフトウェアを 最大限に活用してユーザーに魔法のような 体験を提供する方法をご紹介します 最初に全体の構成を説明します まず Apple Intelligenceを活用した システムレベルの新機能をご紹介します これらの機能を利用するとアプリに 即座にスマートな機能を導入できます 次に OSに組み込まれたモデルを使って 独自の体験の作成に役立つ機械学習を 活用した APIの概要を説明します 続いてその他のオンデバイスのML/AIモデルを 導入するためのオプションをご紹介します 最後に Appleにおける機械学習の 研究についても説明します

各トピックの解説では より詳しく学びたい方 向けの詳細なビデオもご紹介します まず 既にOSに組み込まれている インテリジェンスについて見てみましょう 今年のリリースにおける素晴らしい進化は Apple Intelligenceが基盤となっています これにより アプリとシステム全体に 様々な新機能がもたらされました Writing Toolsなど これらの機能の 多くはみなさんのアプリに導入できます ユーザーは Writing Toolsを使うことで より効果的にコミュニケーションできます 文体や明瞭さを向上させる書き直しや 誤字等の校正 要点のまとめなどが可能です

テキストは Apple Intelligenceの新しい 言語機能で処理されます このツールは アプリで既に使用しているシステムテキストや Webビューとシームレスに統合できます

「Get started with Writing Tools」の ビデオでは 利用可能な機能やアプリへの 導入時に採用すべき ベストプラクティスを紹介しています

次に Image Playgroundをご紹介します Image Playgroundを使うと 画像作成機能をアプリに簡単に組み込めます モデルのトレーニングや安全のための ガードレールの設計は不要です わずか数行のコードでユーザーが画像を 作成して埋め込むための ビルド済みのUIをアプリに組み込めます さらにモデルはオンデバイスでローカルに 実行されるのでユーザーはコストを 心配することなく画像をいくつでも作成できます

今年は Siriに大幅に改良が行われました その結果 Siriはより自然で文脈に即したより パーソナルな印象の発話が できるようになりました 「Bring your app to Siri」のビデオでは App Intent フレームワークを使用して Siriの新機能でアプリを向上させる 方法について詳しく解説しています Appleプラットフォームの主なアプリにおける Siriの体験も刷新され 性能と柔軟性 そして インテリジェンスが向上しました アプリに最小限の変更を加えるだけで優れた 機能をユーザーが利用できるようになります 独自のインテリジェントな機能を提供したい場合 Appleには様々なAPIやフレームワークが 用意されているので モデルの静的な処理を 必要とせずに機能を提供できます 具体的に見てみましょう

Visionフレームワークはテキスト抽出 顔検出や 身体のポーズ認識など視覚的インテリジェンスの 幅広い機能を提供します

統合を効率化するため Appleは今年 Vision向けの Swift 6をサポートする 新しいSwift APIをリリースします さらに Visionでは次の機能も導入されます 身体のポーズのリクエストにおける 手のポーズの検出や 審美性スコアのリクエストです

視覚的理解のための機能をアプリにいかに 簡単に取り入れられるかを「Discover Swift enhancements in the Vision framework」でご確認ください

Vision以外にも様々なフレームワークが 追加されています 自然言語をセグメント化して 理解したり発話をテキストに変換したり音声を 分析して識別したりといった機能を利用できます これらの APIについては過去のWWDCでの 優れたビデオがあります これらの分野でのユースケースを 検討している場合はぜひご視聴ください

今年は言語翻訳のための 新しいフレームワークも導入します このフレームワークは アプリに直接統合できます これをアプリで利用すれば プログラムにより起動できる シンプルな翻訳提示のUIを使って 言語間の直接翻訳ができるようになります あらゆるテキストを翻訳し結果を 任意のUIに表示するためのAPIも提供します この APIを使用するとリクエストを 一括処理してより多くのテキストを 効率的に翻訳することもできます 言語アセットをダウンロードして オンデバイスで管理する方法などの詳細は 「Meet the Translation API」 でご確認ください AppleのMLを活用したAPIは手軽に アプリに導入できる多数の機能を提供します 特定のユースケースに合わせてモデルを カスタマイズする必要がある場合 取り組みを始める際に最適なツールが Create MLです Create MLアプリでは Appleの フレームワークを機能させるためのモデルを デベロッパ独自のデータでカスタマイズできます まずカスタマイズするタスクに合った テンプレートを選びます あとは数回クリックするだけでデータを使って モデルのトレーニング/評価/反復ができます

Create MLアプリに加えて基盤となる Create MLおよび Create MLコンポーネントのフレームワーク では すべてのプラットフォームにおいて アプリ内でモデルをトレーニングできます

今年新たに Create MLアプリに搭載された Object Trackingテンプレートを使用すると visionOSで参照オブジェクトをトレーニングして 空間体験をアンカーできます これによりトレーニング前にデータ注釈を 試したり検査するのがさらに簡単になりました

またフレームワークでは新しい時系列分類や 時系列予測のコンポーネントをアプリに統合できます

各トピックの詳細については「What’s new in Create ML」のビデオをご覧ください

次にオンデバイスでモデルを 実行する方法を解説します これはやや高度なユースケース向けです 例えば微調整と最適化を行った拡散モデルを アプリで使用したり Hugging Faceなどの オープンソースコミュニティから ダウンロードした大規模言語モデルを 実行したりできます Appleデバイスで Whisperや Stable Diffusion そしてMistralなど 幅広いモデルを実行できます 数ステップの操作のみでモデルを アプリ内で実行する準備ができます

デベロッパのワークフローを 詳しく見てみましょう

Appleデバイスへのモデルの デプロイには 3つのフェーズがあります 最初のフェーズではモデルのアーキテクチャを 定義し 適切なトレーニングデータを提供して モデルをトレーニングします

次にモデルをデプロイするために Core ML形式に変換します このフェーズではモデルの表現とパラメータも 最適化して高精度を維持しながら 優れたパフォーマンスを実現します 最後に Appleのフレームワークとの統合を 実現し 準備済みのモデルを読み込んで 実行するためのコードを記述します

各フェーズの詳細を確認しましょう まずはトレーニングです

Appleシリコンと Mac上のユニファイド メモリアーキテクチャを最大限に 活用することで PyTorchや TensorFlow JAXや MLXなどのトレーニングライブラリで 高性能モデルの構築と トレーニングを実行できます これらのライブラリはすべて AppleのGPUでの トレーニング効率化のため Metalを使用します macOSでのモデルのトレーニングの 詳細は「Train your machine learning and AI models on Apple GPUs」でご確認ください このビデオでは Scaled Dot-Product Attentionによる Metalでのトレーニング効率の向上 PyTorchでカスタムの Metalオペレーションの統合方法 新たに追加されたJAXでの 混合精度のサポートについてです 次に準備フェーズについて解説します このフェーズでは Core ML Toolsを使い トレーニング済みのモデルをわずか数 ステップで Core ML 形式に変換します どの PyTorch モデルからでも始められます 次に Core ML Toolsを使って モデルを Core ML 形式に変換します この段階では Core ML Toolsのモデル 最適化ツールキットが提供する様々な 圧縮手法を使用して Appleハードウェア向けに モデルを最適化することもできます Core ML Toolsにおける今年の最新の 機能強化では新しいモデル圧縮手法や モデルの状態を表示する機能のほか Transformer固有の演算や モデルに複数の関数を 保持させる方法が導入されました

これらの機能の詳細とモデルのデプロイにおける ストレージサイズとレイテンシーと精度の間の トレードオフについては「Bring your machine learning and AI models to Apple silicon」 をご覧ください

モデルの変換と最適化が完了したら 次のステップはモデルの統合です

この段階では OSのフレームワークとの インターフェイスを実現してモデルを読み込み 推論を実行するためのコードを記述します

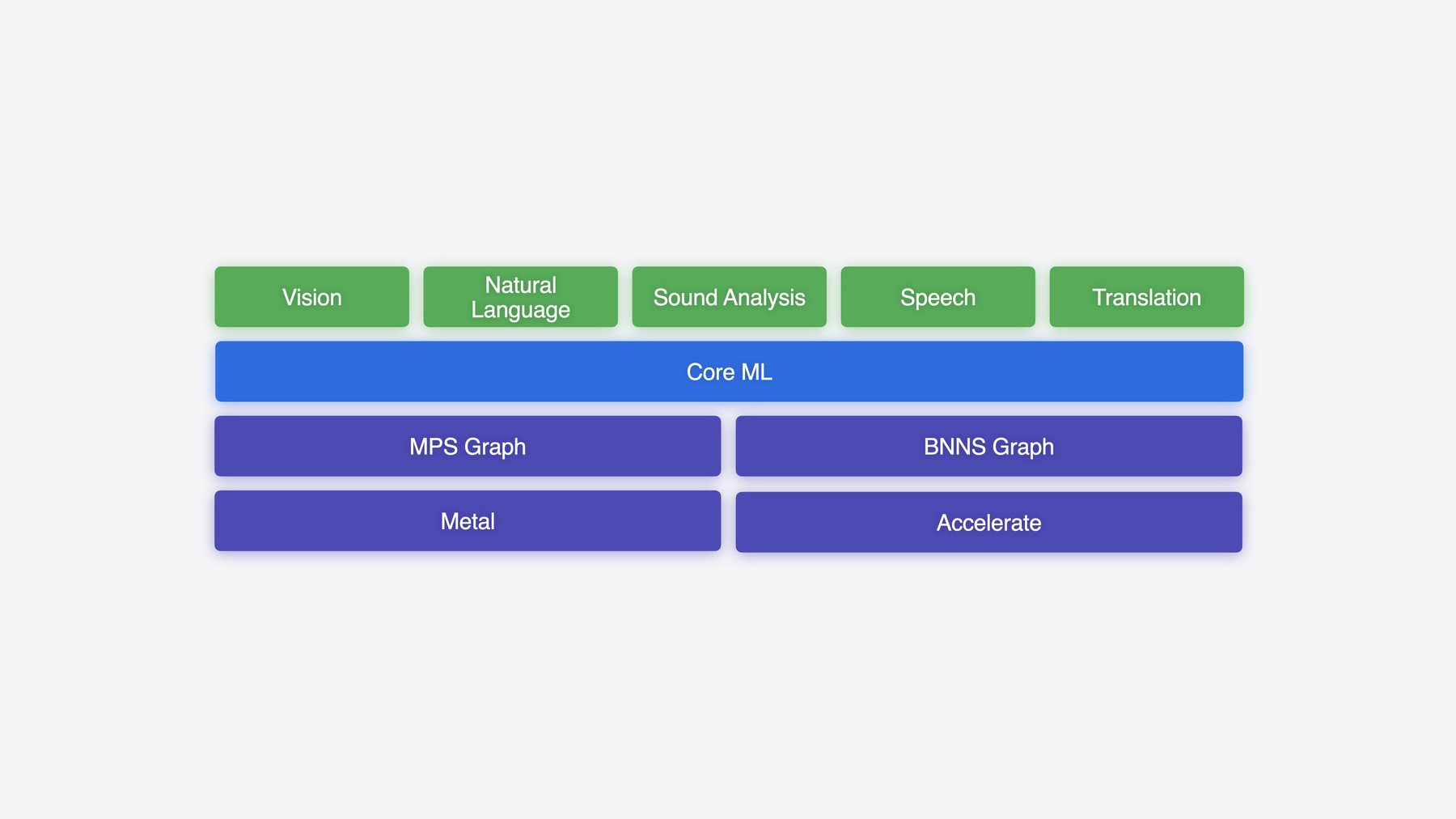

Core MLはモデルを Appleデバイスに デプロイするためのゲートウェイであり 卓越した体験を提供するために 数千ものアプリで使用されています 優れたユーザー体験の実現に不可欠な パフォーマンスを提供すると同時に Xcodeとの統合によって 開発ワークフローを簡素化します Core MLは CPUやGPU および Neural Engineの全体で モデルを自動で分割し ハードウェアの利用率を最大化します

「Deploy machine learning and AI models on-device with Core ML」では最先端の生成AIモデルを オンデバイスで実行するうえで役立つ Core MLの新機能を紹介しています

ここではまず新しい MLTensorの型を 紹介します これはモデルを結合する 計算用のグルーコードを簡素化するために 設計されたものです

次に状態を使用して大規模言語モデルを 効率的にデコードするために キー値キャッシュを管理する方法を学びます その後画像生成モデルの実行時に特定の スタイルアダプタを選択するために 関数を使用する方法を説明します

モデルの各オペレーションのコストについて より詳細な情報を得られる パフォーマンスレポートの アップデートについても解説します

Core MLはデバイスへのモデルのデプロイに 有用なフレームワークです しかし機械学習タスクの実行時に きめ細かい制御が必要な場合もあります 例えばアプリに高負荷のグラフィックス ワークロードがある場合 Metalの MPS Graphを使えば機械学習タスクと 他のワークロードの順序を指定し GPU利用率を最適化できます CPUでのリアルタイムの信号処理の実行時に Accelerateの BNNS Graph APIを 使えば MLタスクの遅延とメモリの 管理を厳密に制御できます

これらのフレームワークは Core MLの基盤の 一部であり みなさんにご利用いただけます 各オプションの詳細を確認しましょう まずはMPS Graphです MPS Graphは Metal Performance Shaders上に構築されており Core MLモデルの読み込みや Metalを用いたプログラムによる 計算グラフの構築や コンパイル実行を可能にします 「Accelerate machine learning with Metal」では GPUでの Transformerの効率的な実行方法や 計算とメモリの帯域幅を向上させる MPS Graphの新機能について 詳しく説明しています 新しい MPS Graphの Stride NDArray APIがどのようにフーリエ変換の高速化に 役立つか説明します またモデルの実行に 関する理解を助け インサイトを提供する 新しいMPS Graphビューアも紹介します

次は BNNS Graphです BNNS Graphは CPU上での機械学習モデルの 実行を最適化するための Accelerateフレームワークの 新しいAPIです BNNS Graphは従来型の BNNS カーネルベースのAPIと比べ パフォーマンスが大幅に向上しています Core MLモデルと連携し 遅延の影響を受け やすいリアルタイムの推論をCPU上で実行し メモリ割り当ての厳密な制御を可能にします 音声処理などのユースケースに最適です BNNS Graphに関する今年の最新情報の 詳細は「Support real-time ML inference on the CPU」をご覧ください AppleのフレームワークとAPIは 機械学習モデルとAIモデルの推論を ローカルで実行するために必要なすべての 機能を提供して Appleシリコンの ハードウェアアクセラレーションの 効果をフル活用できるようにします また各ドメインのAPIに加え Apple プラットフォーム上の様々な 最先端の機械学習ツールや APIもアプリで利用できます ニーズやユーザー体験に応じてAppleのモデルを 活用したシンプルな既製APIから始めることも Appleのフレームワークを使って機械学習と AIのモデルを直接デプロイすることもできます

Appleはアプリでのインテリジェントな 体験の構築を支援する機械学習と AIを活用した最適な基盤の提供に 尽力しています ここまで説明してきた機能は OSと デベロッパSDKに組み込まれています 次は最後のトピックである 研究に移ります Appleは機械学習とAIの 最先端を常にリードしています これまでに何百もの論文を発表し AIモデルやオンデバイスでの最適化への 新しいアプローチを提起しています またさらなる探究を促進するために サンプルコードやデータセット MLXなどの研究ツールを オープンソースで公開しています

MLXは Appleの機械学習研究者が 他の 研究者による使用を想定してデザインしています 研究者は拡張性のある使い慣れた APIを使って Appleシリコンで新しいアイデアを検討できます ユニファイドメモリモデルを基盤として 構築されているため CPUとGPUをまたいだ効率的な演算が可能です また MLXでの探究は Pythonや C++または Swiftで実行できます 詳細を確認し オープンソースに貢献するには MLXの GitHubページにアクセスしてください オープンソースに最近加わったのがCoreNetです これは研究者やエンジニア向けに 設計されたパワフルな ニューラルネットワークツールキットです この汎用的なフレームワークを使えば アーキテクチャが標準的か先進的かを問わず 幅広いモデルをトレーニングでき モデルのスケールを 柔軟に調整して様々なタスクに 取り組むことができます また CoreNetの一部として OpenELMもリリースしました OpenELMは効率的な言語モデルファミリー でありトレーニングと推論のための オープンなフレームワークを提供します このモデルはオープンソースコミュニティが すでにMLXとCore ML形式に変換しており Appleデバイスで実行可能です 以上 ほんの一部ではありますが Apple プラットフォームでの機械学習の概要でした 本日説明した内容をまとめます 標準のUI要素を利用することで OS組み込みの インテリジェンスを活用し シームレスなユーザー体験を構築できます MLを活用した APIや Create MLで カスタマイズすることでアプリを 次のレベルに引き上げられます Metalを活用した PyTorchなどの使い慣れた フレームワークによりパワフルな Mac GPU上でモデルのトレーニングや 微調整ができます それらのモデルを Core ML Toolsで Appleシリコン向けに最適化することで デプロイの準備ができます Core ML、MPS Graph、BNNS Graphの各APIを使ってこれらのモデルを 組み込めばアプリを通じて 驚異的な体験を提供できます またオープンソースのフレームワークと モデルを取り上げた Appleによる 最先端の研究イニシアティブもご覧ください ユーザーのための素晴らしい体験の 構築をさっそく始めましょう

-